Projektowanie dźwięku w grach

Aby osiągnąć ujednolicony projekt dźwięku w grach i pełniejsze zrozumienie sekwencji dźwięków, można je podzielić na kilka typów: aktorstwo głosowe, atmosfery (dźwięki otoczenia), szumy synchroniczne (fols), efekty dźwiękowe (CFX) i muzyka.

Istnieje kilka sposobów wykorzystania głosu w grach. Głównym źródłem informacji dla użytkowników są dialogi dźwięczne. Frazy spikera nagradzają gracza (np. „Podwójne zabicie”) lub zapowiadają określone działania („Runda pierwsza – walka”). Podkład głosowy działań głównego bohatera, takich jak krzyk podczas otrzymywania obrażeń lub skakania, odgłos oddechu podczas biegu, pomaga wzmocnić więź z postacią i lepiej oddać jej stan.

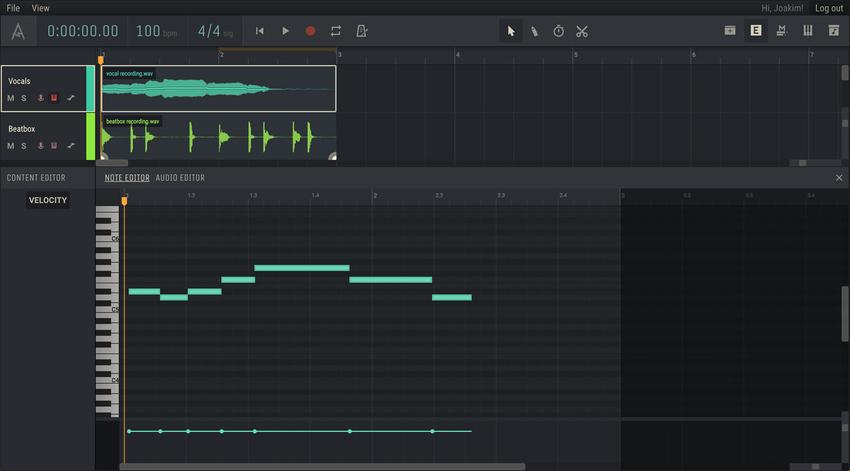

Podczas pracy z aktorstwem głosowym ważny jest dobór aktorów o odpowiedniej barwie głosu, tak aby ich głos pasował do charakteru postaci. Głos NPC powinien wywołać u gracza poczucie rzeczywistości. Jeśli postać jest potworem lub kosmitą, należy podkreślić cechy wymowy i cechy aparatu mowy. Aby to zrobić, projektanci dźwięku używają narzędzi do zmiany wysokości tonu i nakładania warstw dźwięku, takich jak odpowiednio Pitch i Layering. Narzędzia te pozwalają zmieniać wysokość i czas trwania dźwięku, a także tworzyć kompozycje z różnych warstw i tekstur. Ponadto należy wziąć pod uwagę wykorzystanie efektów.

Odtwarzanie głosu w grze jest zwykle powiązane z drzewem dialogowym lub wyzwalaczem.

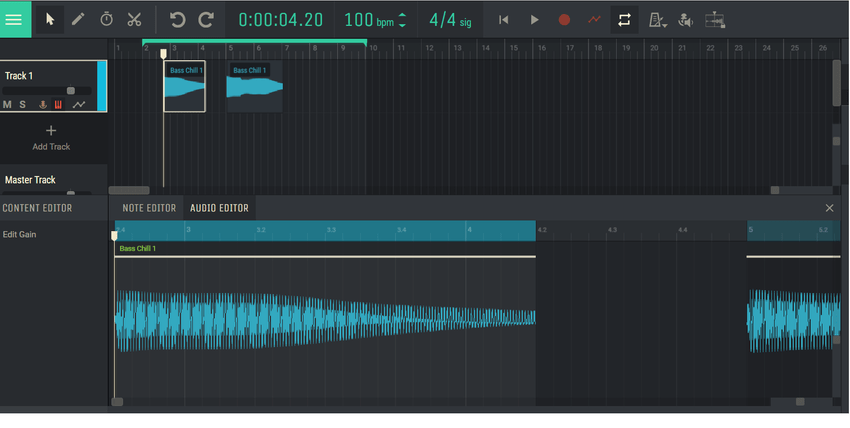

Aby stworzyć atmosferę, ważne jest użycie zapętlonych próbek audio, w których koniec pliku audio płynnie przechodzi do początku. Ważne jest, aby upewnić się, że nie ma zauważalnych przeskoków i używać dźwięków o długości co najmniej jednej minuty (najlepiej co najmniej pięciu minut), aby stworzyć iluzję ciągłego dźwięku w tle. Każde nagłe przejście może przerwać immersję gracza.

Dodając dźwięki tła do wirtualnego świata, należy wziąć pod uwagę ich rozmieszczenie na mapie. Na przykład, jeśli jest to dżungla, ogólne dźwięki, takie jak śpiew ptaków, szum wodospadu czy szelest, powinny być zawsze obecne. Każdy obiekt ma swoją strefę dźwiękową, którą można podzielić na dwa poziomy: strefę narastania i strefę stałej głośności. Proces ten nazywany jest tłumieniem.

Gdy gracz wejdzie do pierwszej strefy, głośność dźwięku wzrasta w miarę zbliżania się do źródła.

Proces ten trwa, dopóki użytkownik nie zbliży się wystarczająco blisko. Następnie gracz przechodzi do drugiej strefy, w której głośność dźwięku pozostaje niezmieniona. Jest to ważne przy pozycjonowaniu i mieszaniu stref, ponieważ dźwięki z różnych źródeł mogą się na siebie nakładać. Dźwięki tła umieszczane są bezpośrednio w lokalizacjach i ważne jest, aby nie wychodziły poza obszar ich działania. Tworząc atmosferę sprzyjającą orientacji w świecie gry, brane są pod uwagę następujące parametry:

- Głośność: poziom głośności dźwięku;

- Pozycjonowanie: określanie lokalizacji dźwięku w przestrzeni;

- Priorytet: określenie ważności dźwięku w stosunku do innych dźwięków;

- Pogłos: Odbicie dźwięku w zamkniętych przestrzeniach, tworzące echo.

Pracując z dźwiękiem należy zwrócić uwagę na główne elementy gry, tzw. akcenty, które kształtują doświadczenia użytkownika. Przydatne są w tym celu procesy miksowania dźwięku i ustalania priorytetów.

Przykładowo, gdy pojawia się wróg, dźwięki jakie wydaje należy wyraźnie odróżnić od tła otoczenia. Istnieją różne sposoby osiągnięcia tego zadania:

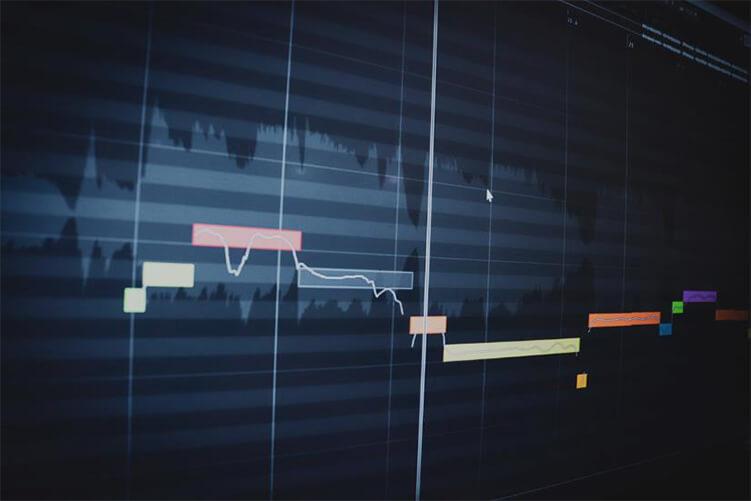

- Rozkład warstw dźwiękowych na różnych kanałach audio i ich miksowanie;

- Priorytetyzacja dźwięków w oparciu o logikę gry.

Wykorzystanie efektu Sidechain, który umożliwia zmianę głośności dźwięków w zależności od priorytetów. Na przykład, gdy pojawi się wróg i zabrzmią jego dźwięki, inne głośne dźwięki automatycznie ucichną.

Pogłos ma także ogromne znaczenie przy rozmieszczaniu dźwięków na mapie. Należy pamiętać, że dźwięk taki jak trzaskanie palcami będzie brzmiał inaczej w pomieszczeniu i w jaskini ze względu na odbicia od ścian i powierzchni. Narzędzie Reverb może pomóc w tym zadaniu.

Strefy pogłosu zwykle odpowiadają pomieszczeniom, w których znajdują się atmosfery i mogą ze sobą oddziaływać. Ważne jest zapewnienie jedności przestrzeni dla wszystkich warstw dźwiękowych w scenie, a także wykorzystanie pogłosu jako głównego narzędzia do tworzenia efektu podejścia i usuwania dźwięku.

Synchroniczne nagrywanie hałasu (foley) często odbywa się w studiu w celu osiągnięcia autentyczności i wysokiej jakości dźwięku. W przeszłości korzystanie z nagrań dźwiękowych na planie było trudne ze względu na hałas kamer. Jack Foley, amerykański inżynier dźwięku działający w branży filmowej, opracował system, w którym dźwięk był rejestrowany oddzielnie od obrazu wideo na ekranie, ale zsynchronizowany z nim.

Dźwięki synchroniczne powstają obecnie także w wyspecjalizowanych studiach. Aby uzyskać pożądany dźwięk, nie jest konieczne stosowanie naturalnych materiałów. Na przykład papier i specjalne efekty dźwiękowe można wykorzystać do naśladowania dźwięku prądu elektrycznego, a worek skrobi można wykorzystać do stworzenia dźwięku śniegu.

Najbardziej efektywnym sposobem łączenia dźwięków synchronicznych jest mapowanie ich bezpośrednio do animacji. Przykładowo, aby zabrzmiał odgłos kroków postaci, trzeba określić moment, w którym stopa dotyka powierzchni i do tego momentu dopisać odpowiedni dźwięk. Ważne jest, aby wybrać odpowiedni dźwięk, który zależy od materiału, po którym postać stąpa.

SFX to efekty dźwiękowe, które nie istnieją w rzeczywistości: odgłosy kosmitów, statków kosmicznych, a także akcenty, na które gracz powinien zwrócić uwagę – eksplozje, wystrzały, dźwięki interfejsu. Bardzo ważne jest, aby SFX pasowało do ustawień gry. Na przykład podczas tworzenia dźwięków interfejsu można używać dźwięków o tej samej fakturze (szkło, kamień, drewno), aby zapewnić jednolity dźwięk.

Efekty dźwiękowe są umieszczane w lokalizacjach w taki sam sposób, jak efekty dźwiękowe, lub mogą być powiązane z określonymi wyzwalaczami lub animacjami.

Muzyka służy do tworzenia określonego nastroju w scenie. Doskonale oddaje stan emocjonalny i dramaturgię. Muzyka może być w klatce (źródło dźwięku znajduje się w scenie: gramofon, fortepian) lub poza ekranem. Umieszczanie muzyki odbywa się w taki sam sposób, jak dźwięki tła. Jest prawie zawsze używany w przerywnikach filmowych i jest prostym i skutecznym sposobem powiązania projektu audio w grach.

Muzykę w grach dzieli się zazwyczaj na dwa rodzaje:

- Muzyka adaptacyjna;

- Muzyka liniowa.

Muzyka adaptacyjna służy do płynnej interakcji z rozgrywką i dopasowywania intensywności i dramatyzmu tego, co się dzieje. Aby to jednak osiągnąć, konieczne jest wykonanie płynnych przejść pomiędzy różnymi segmentami kompozycji.

Na przykład mamy zapętlony segment muzyczny A, który jest połączony z prostym spacerem postaci. Kiedy gracz zbliży się do lawy i aktywuje spust, rozpoczyna się część B. Aby zapewnić płynne przejście, należy wstępnie rozważyć możliwość zmiany składu.

Istnieje poziomy typ przejścia, który obejmuje przejście z pierwszego segmentu do drugiego, od drugiego do trzeciego i tak dalej. Każdy segment jest podzielony na części, które mają własne warunki przejścia do następnego. Można na przykład nagrać specjalną część końcową, która jest uwzględniana przy przejściu do innego segmentu.

Istnieje również metoda pionowa, gdzie wykorzystuje się wspólną melodię tła, uzupełnianą innymi warstwami muzycznymi w przypadku przemieszczania się w różne miejsca lub zmiany tempa gry. Na przykład może zostać uwzględniona zmodyfikowana wersja motywu głównego. Ważne jest, aby wszystkie te części były ze sobą zwięźle połączone i tworzyły harmonijny dźwięk.

Aby stworzyć zrównoważony projekt dźwiękowy w grach, ważne jest przestrzeganie pewnych zasad:

- Stosowanie odpowiednich tekstur dźwiękowych: nie zastępuj dźwięku przedmiotu plastikowego dźwiękiem przedmiotu metalowego;

- Zgodność z zaplanowanym dźwiękiem;

- Stosowanie akcentów w celu zwrócenia uwagi na kluczowe elementy;

- Uwzględnianie pierwszeństwa dźwięków.

Ponadto ważne jest zrozumienie cech dźwięku. Na przykład, gdy sterowiec znajduje się za górą i nie jest widoczny, ale słychać, nie słychać dźwięków o wysokiej częstotliwości. Kiedy sterowiec wyłania się zza góry, częstotliwości się zgadzają i następuje pogłos, echo z wąwozu. Im bliżej obiektu, tym mniejsze echo. Im większy obiekt, tym więcej odpowiada mu tekstur dźwięku o niskiej częstotliwości. Wiele takich niuansów ujawnia się wraz z doświadczeniem.