Normalizacja dźwięku

W ciągu ostatnich trzydziestu lat sposób, w jaki docieramy do muzyki, przeszedł radykalne zmiany. Wraz z pojawieniem się usług cyfrowego przesyłania strumieniowego i technologii cyfrowego przetwarzania sygnału (DSP), standardowa normalizacja dźwięku stała się integralną częścią tego procesu.

Ale co oznacza normalizacja dźwięku i jak można przeprowadzić ten proces w przypadku własnych cyfrowych plików audio? Przyjrzyjmy się, czym jest normalizacja dźwięku i dlaczego jest to kluczowy etap współczesnej twórczości muzycznej.

Sekwencer online Amped Studio oferuje kompletną listę funkcji do pełnej normalizacji dźwięku, co pozwala na profesjonalne przetwarzanie utworów.

Co to jest normalizacja dźwięku?

Podczas procesu normalizacji dźwięku do cyfrowego pliku audio stosuje się określone wzmocnienie, które doprowadza go do określonego poziomu amplitudy lub głośności, zachowując jednocześnie zakres dynamiczny ścieżek.

Normalizacja dźwięku jest często używana w celu maksymalizacji głośności wybranego klipu audio i zapewnienia spójności między różnymi klipami audio, na przykład w albumie lub EP zawierającym wiele ścieżek.

Należy pamiętać, że skuteczne normalizowanie kompozycji o szerokim zakresie dynamicznym może być trudniejsze. Podczas procesu normalizacji mogą wystąpić problemy takie jak spłaszczenie lub zniekształcenie amplitudy szczytowej.

Dlatego każdy klip audio wymaga indywidualnego podejścia podczas normalizacji. Normalizacja dźwięku jest integralną częścią cyfrowego przetwarzania nagrań, ale nie ma jednego uniwersalnego podejścia do tego procesu.

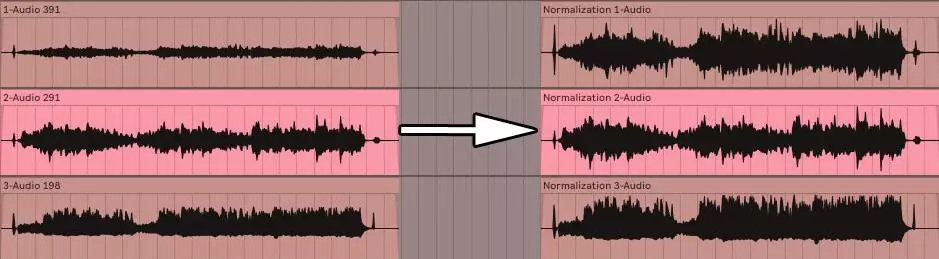

Przed i po normalizacji dźwięku

Dlaczego musisz normalizować dźwięk?

Dlaczego normalizacja plików audio jest tak ważna? Oto kilka scenariuszy, w których normalizacja głośności jest koniecznością:

Przygotowanie do pracy z usługami streamingowymi

Usługi przesyłania strumieniowego automatycznie ustawiają standardowy poziom głośności dla wszystkich utworów w swoich bibliotekach, eliminując potrzebę regulacji głośności podczas słuchania. Każda platforma ma swoje własne docelowe LUF, aby zapewnić spójny dźwięk:

- • Spotify : -14 LUFS;

- • Apple Music : -16 LUFS;

- • Amazon Music : od -9 do -13 LUFS;

- • Youtube : od -13 do -15 LUFS;

- • Deezer : od -14 do -16 LUFS;

- • CD : -9 LUFS;

- • Soundcloud : od -8 do -13 LUFS.

Chociaż każdy inżynier dźwięku może mieć inne podejście do określania docelowego poziomu głośności do masteringu, standardy te stanowią ważne wytyczne zapewniające spójne odtwarzanie muzyki na różnych platformach.

Osiągnięcie maksymalnej głośności

Korzystanie z normalizacji dźwięku pomaga osiągnąć maksymalny poziom głośności dla każdego pliku audio. Jest to szczególnie przydatne podczas importowania utworów do programów do edycji audio lub w celu zwiększenia głośności pojedynczego pliku audio.

Tworzenie pojedynczej warstwy pomiędzy wieloma plikami audio

Możliwe jest także kondycjonowanie plików audio do tego samego poziomu głośności, co jest ważne przy procesach takich jak mastering, gdzie konieczne jest ustawienie odpowiednich poziomów dźwięku do późniejszej obróbki.

Dodatkowo po ukończeniu projektu muzycznego, takiego jak album lub EP, możesz normalizować i edytować pliki audio. Ponieważ chcesz, aby atmosfera i dźwięk całego nagrania były spójne, może być konieczne cofnięcie się i dostosowanie poziomu głośności tak, aby pasował do wszystkich utworów.

Dwa rodzaje normalizacji dźwięku

Do różnych celów wykorzystania nagrań dźwiękowych stosuje się różne metody normalizacji dźwięku. Zwykle sprowadza się to do dwóch głównych typów: normalizacji szczytowej i normalizacji głośności.

Normalizacja szczytowa

Proces normalizacji szczytowej jest metodą liniową, w której stosuje się równomierne zwiększanie sygnału audio, aby osiągnąć poziom odpowiadający maksymalnej amplitudzie ścieżki audio. Zakres dynamiki pozostaje taki sam, a nowy plik audio brzmi w przybliżeniu tak samo, z tą różnicą, że poziom głośności może być wyższy lub niższy. Proces ten określa najwyższą wartość PCM lub wartość modulacji kodu impulsowego w pliku audio. Istotą normalizacji wartości szczytowych jest przetwarzanie dźwięku w oparciu o górną granicę cyfrowego systemu audio, która zazwyczaj odpowiada maksymalnej wartości szczytowej wynoszącej 0 decybeli. Szczytowy efekt normalizacji opiera się wyłącznie na szczytowych poziomach dźwięku, a nie na postrzeganej głośności ścieżki.

Normalizacja objętości

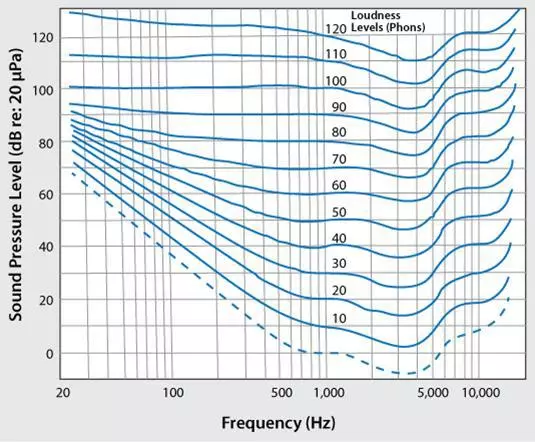

Proces normalizacji głośności jest bardziej złożony, ponieważ uwzględnia cechy percepcji dźwięku przez człowieka. Ucho ludzkie jest w stanie rozróżnić różne poziomy głośności i amplitudy poszczególnych dźwięków, z zastrzeżeniem pewnych subiektywnych ograniczeń. Przetwarzanie to jest często określane jako określanie głośności EBU R 128.

Na przykład dźwięki odtwarzane przez długi czas z tym samym poziomem głośności mogą wydawać się głośniejsze niż dźwięki odtwarzane sporadycznie lub chwilowo, nawet jeśli poziomy głośności są takie same. Dzieje się tak ze względu na sposób, w jaki ludzkie ucho odbiera dźwięk. Dlatego przy normalizowaniu głośności należy wziąć pod uwagę te cechy percepcyjne.

Niektórzy uważają, że głośniejsza muzyka brzmi atrakcyjniej. To właśnie ten pogląd dał początek „wojnom głośności” przed pojawieniem się usług przesyłania strumieniowego, podczas których muzycy starali się zmaksymalizować szczytową głośność swoich nagrań, aby stworzyć bardziej wyrazisty i kolorowy dźwięk. Jednak dzięki normalizacji dźwięku zjawisko to należy już do przeszłości i teraz przejściu pomiędzy utworami nie towarzyszą nagłe zmiany głośności.

LUF służą do pomiaru poziomów głośności, aby lepiej odpowiadały ludzkiemu postrzeganiu dźwięku. Standard ten jest szeroko stosowany w usługach filmowych, telewizyjnych, radiowych i streamingowych. Podobnie jak w przypadku normalizacji wartości szczytowych, standardem pozostaje 0 dB.

Jak stwierdzono powyżej, krzywa Fletchera-Munsona może pomóc w wyjaśnieniu różnic branych pod uwagę przy normalizacji głośności w LUF.

Standardy głośności różnią się w zależności od regionu i zastosowania

- 24 LUFS: ATSC A/85 (telewizja amerykańska), NPRSS, transmisja radiowa PRX;

- 23 LUFS: tłumaczenie EBU R 128;

- -19 do -16 LUFS: podcasty PRX;

- 14 LUFS: Spotify, YouTube i inne platformy streamingowe.

Wyznaczanie średniej objętości kwadratowej

Jeśli nie zamierzasz normalizować kanałów stereo za pomocą normalizacji poziomu szczytowego, prawdopodobnie zastosujesz normalizację głośności, ale warto również wspomnieć o innej technice przetwarzania głośności, głośności RMS.

Proces normalizacji jest podobny do normalizacji głośności w LUF, ale zamiast tego używane są poziomy RMS. Root Mean Square (RMS) mierzy średnią głośność sekcji lub całego czasu trwania klipu.

Jednakże, podobnie jak normalizacja oparta na najwyższym piku, normalizacja RMS nie uwzględnia ludzkiego słuchu. Właśnie dlatego inżynierowie zajmujący się masteringiem zazwyczaj pracują w standardzie z LUF i procesami normalizacji. Mastering nie polega tylko na zapewnieniu spójności głośności w całym projekcie. Ważne jest również, aby cofnąć się o krok i wziąć pod uwagę dynamikę, ludzką percepcję i równowagę pomiędzy każdym utworem.

Kiedy stosować normalizację

Teraz, gdy już wiesz, czym jest normalizacja dźwięku, porozmawiajmy o tym, kiedy i jak należy z niej korzystać.

Opanuj swoją muzykę

Normalizacja dźwięku jest kluczowym narzędziem w procesie masteringu ścieżki.

Podczas masteringu ważne jest utrzymanie stałego poziomu głośności utworów.

Dzięki temu Twoi słuchacze mogą cieszyć się muzyką bez konieczności ciągłego dostosowywania głośności.

Normalizując utwory, na przykład podczas tworzenia post-miksu/mastera albumu, możesz uzyskać profesjonalny, dopracowany dźwięk.

Taki, który spełnia standardy wydania komercyjnego i jest gotowy do dystrybucji.

A skoro mowa o masteringu, jeśli szukasz najlepszych wtyczek do masteringu, jesteśmy tutaj, aby pomóc Ci je znaleźć.

Przygotowanie do usług przesyłania strumieniowego

Usługi przesyłania strumieniowego mają określone wymagania dotyczące głośności, które należy wziąć pod uwagę podczas pobierania muzyki.

Normalizacja może pomóc w spełnieniu tych wymagań, zapewniając doskonałą jakość dźwięku na tych platformach.

Normalizując pliki w celu dopasowania ich do docelowego poziomu usługi przesyłania strumieniowego, zapewniasz swoim fanom stałą jakość odtwarzania.

Jeśli jednak nie przejdziesz przez ten proces samodzielnie, usługi przesyłania strumieniowego mogą zrobić to za Ciebie, korzystając z kompresji, ograniczania i innych technik.

Może to prowadzić do poważnych problemów z jakością dźwięku.

Zawsze pamiętaj, aby sprawdzić zalecenia dotyczące głośności dla każdej konkretnej usługi przesyłania strumieniowego, ponieważ wymagania mogą się różnić.

Praca z różnymi plikami audio

Podczas pracy z wieloma plikami audio w projekcie ważne jest, aby poziom głośności był taki sam dla wszystkich.

Jest to szczególnie ważne, jeśli pliki audio mają różne źródła lub są nagrane z różną głośnością.

Jest to szczególnie ważne, jeśli pliki audio mają różne źródła lub są nagrane z różną głośnością.

Jest to szczególnie ważne, jeśli pliki audio mają różne źródła lub są nagrane z różną głośnością.

Typowe błędne przekonania na temat normalizacji dźwięku

Myślę, że bardzo ważne jest, aby przed podjęciem dalszych działań rozważyć kilka powszechnych błędnych przekonań, szczególnie w przypadku tych, którzy dopiero zaczynają.

1. Normalizacja i kompresja dźwięku to dwie różne rzeczy

Niektórzy mylą normalizację z kompresją, ale mają one zupełnie inne cele.

Podczas gdy normalizacja dostosowuje ogólny poziom głośności pliku audio, kompresja zmniejsza zakres dynamiczny pliku.

Kompresja może pomóc w stworzeniu bardziej stabilnego poziomu głośności w pliku audio, ale niekoniecznie zwiększa ogólny poziom głośności nowego pliku audio.

Chyba, że taki jest Twój cel, oczywiście.

Kompresja jest zwykle używana do korekcji dynamicznej i ulepszania dźwięku, podczas gdy normalizacja jest funkcją bardziej utylitarną.

Jeśli szukasz najlepszych wtyczek kompresujących do tego procesu, nie szukaj dalej.

2. Normalizacja dźwięku nie naprawia wszystkiego

Należy pamiętać, że normalizacja szczytowa nie rozwiązuje wszystkich problemów z dźwiękiem.

Jeśli masz problemy ze stosunkiem sygnału do szumu, zniekształceniami lub innymi artefaktami audio, sama normalizacja nie rozwiąże tych problemów.

W takich przypadkach należy zająć się pierwotnymi przyczynami problemu i zastosować inne techniki przetwarzania dźwięku, takie jak korektor lub redukcja szumów, aby uzyskać pożądany dźwięk.

Jeśli zaistnieje taka sytuacja, mamy najlepsze wtyczki korektora 2023 roku.

3. Normalizacja dźwięku nie zwiększa rezerw mocy

Podczas normalizowania plików audio ważne jest, aby zachować wystarczający zapas głośności w miksach i nagraniach.

Nadwyżka to różnica między najgłośniejszym punktem pliku audio a maksymalnym poziomem głośności, jaki może obsłużyć cyfrowy system audio.

Jeśli zbyt agresywnie normalizujesz dźwięk, ryzykujesz zniekształceniami i obcinaniem, co może negatywnie wpłynąć na jakość Twojej muzyki.

Pamiętaj, że niezależnie od tego, jakiego DAW lub systemu używasz, ważne jest, aby monitorować wszystko powyżej znaku 0 dB.

Dzieje się tak dlatego, że unikanie ograniczeń i posiadanie wystarczającego marginesu pozwala uniknąć zniekształceń.

Na przykład lubię uważać -16dB za docelowy zapas mocy, a do wszystkiego powyżej używam ogranicznika (tylko po to, aby zachować odpowiedni zapas).

Pomaga to również zrekompensować wszelkie niezbędne zmiany głośności na etapie masteringu.

Proces normalizacji dźwięku

Teraz, gdy omówiliśmy najczęstsze błędne przekonania na temat normalizacji dźwięku, przyjrzyjmy się bliżej samemu procesowi.

Przeanalizuj swoje pliki audio

Przed normalizacją plików audio ważne jest ich przeanalizowanie i określenie aktualnego poziomu głośności.

Analizę tę można przeprowadzić za pomocą narzędzi wbudowanych w DAW lub za pomocą dedykowanego oprogramowania do analizy dźwięku.

Znając bieżący poziom głośności plików, możesz podejmować świadome decyzje dotyczące procesu normalizacji dźwięku.

Wybieranie celu normalizacji dźwięku

Po przeanalizowaniu plików możesz wybrać cel normalizacji, który najlepiej odpowiada Twoim potrzebom.

Czynniki, które należy wziąć pod uwagę przy wyborze metody normalizacji, obejmują:

- Rodzaj materiału audio;

- Żądany poziom głośności;

- Rodzaj wykonywanego przetwarzania;

- Platforma docelowa dla Twojej muzyki.

Każdy poziom normalizacji ma swoje mocne i słabe strony, dlatego ważne jest, aby wybrać ten, który zapewni najlepsze wyniki w konkretnej sytuacji.

- W mieszanych sytuacjach . Pozostań na niskich dwucyfrowych wartościach, najlepiej od -18 do -12 dB;

- W celach masteringowych . Bezpieczną opcją byłaby dowolna wartość pomiędzy -8 a -3 dB.

W niektórych usługach przesyłania strumieniowego i sytuacjach może zaistnieć sytuacja, w której gwarantowane jest -0 dB, więc upewnij się, że nie przekracza tej wartości, ponieważ jest tuż na granicy limitu.

Notatka. Podczas procesu miksowania ważne jest zwrócenie szczególnej uwagi na ustawienia wzmocnienia, a także określenie głośności RMS, aby określić wielkość wzmocnienia potrzebną dla każdej ścieżki.

Korzystanie z kontroli wzmocnienia klipu może pomóc w uzyskaniu precyzyjnej kontroli nad poziomami głośności, zapewniając dobrze zrównoważony miks.

Normalizacja dźwięku

Po wybraniu odpowiedniego celu normalizacji możesz edytować pliki audio za pomocą DAW lub dedykowanego oprogramowania do edycji dźwięku.

Większość programów DAW i programów do edycji dźwięku ma wbudowane narzędzia normalizacyjne, dzięki którym są łatwe w użyciu.

Zwykle jest to tak proste, jak zaznaczenie dźwięku i naciśnięcie polecenia lub po prostu wybranie „Normalizuj” z menu rozwijanego.

Pamiętaj, aby monitorować wyniki procesu normalizacji, aby upewnić się, że nowe poziomy głośności spełniają Twoje oczekiwania i nie powodują niepożądanych artefaktów lub problemów.

Kompresja a normalizacja

Jeśli chodzi o normalizację, najczęściej porównuje się ją do procesu kompresji. Zrozumienie różnic i wybór właściwej metody przetwarzania dźwięku to kluczowe umiejętności producenta muzycznego, dlatego przyjrzyjmy się temu bliżej.

Kompresja i normalizacja to dwie odrębne techniki przetwarzania dźwięku, z których każda ma swoje własne, unikalne cele.

- Normalizacja ma na celu dostosowanie ogólnego poziomu głośności pliku audio;

- Kompresja z kolei zmniejsza zakres dynamiki pliku.

Należy pamiętać, że kompresja powoduje, że cichsze fragmenty pliku audio stają się głośniejsze, a głośniejsze cichsze. Chociaż obie metody można zastosować w celu uzyskania bardziej spójnego poziomu głośności, wpływają one w różny sposób na dźwięk i mogą mieć inny wpływ na materiał.

Tak, kompresja może sprawić, że dźwięk będzie głośniejszy, ale jej głównym celem jest coś innego.

Kiedy stosować kompresję

Normalizacja to proces, który przydaje się, gdy trzeba wyrównać ogólny poziom głośności pliku audio lub grupy plików. Jak wspomnieliśmy wcześniej, jest to szczególnie przydatne podczas masteringu ścieżki dźwiękowej lub przygotowywania muzyki do usług przesyłania strumieniowego. W przeciwieństwie do kompresji normalizacja nie wpływa na zakres dynamiczny pliku audio, dzięki czemu jest bardziej przejrzystą i mniej inwazyjną metodą przetwarzania. Co więcej, nie implikuje również żadnych dynamicznych, korygujących lub ulepszających celów, znaczeń lub właściwości.

Kiedy stosować normalizację głośności

Normalizacja to narzędzie, którego należy użyć, gdy chcesz wyrównać ogólny poziom głośności pliku audio lub grupy plików. Jak wspomniano wcześniej, jest to szczególnie ważne podczas masteringu ścieżki dźwiękowej lub przygotowywania muzyki do usług przesyłania strumieniowego. W przeciwieństwie do kompresji normalizacja nie zmienia zakresu dynamiki pliku audio, czyniąc go bardziej neutralnym i mniej inwazyjnym dla dźwięku. Ponadto nie ma na celu poprawiania ani ulepszania właściwości dynamicznych pliku audio.

Dynamika i ucho ludzkie

Ludzki układ słuchowy to złożony mechanizm, który reaguje na różne częstotliwości i poziomy głośności. Nasze postrzeganie dźwięku jest nieliniowe: zmiany poziomu głośności i częstotliwości są postrzegane w różny sposób.

Podczas normalizowania plików audio należy wziąć pod uwagę tę nieliniową naturę percepcji, ponieważ może ona wpływać na sposób, w jaki słuchacze odbierają muzykę.

Krzywe jednakowej głośności, zwane krzywymi Fletchera-Munsona, przedstawiają, jak ludzkie ucho reaguje na głośność przy różnych częstotliwościach. Pokazują, że słuch jest bardziej wrażliwy na pewne zakresy częstotliwości, zwłaszcza od 2 do 5 kHz, a mniej wrażliwy na bardzo niskie i wysokie częstotliwości.

Znajomość tych krzywych może pomóc w podejmowaniu świadomych decyzji dotyczących ludzkiej percepcji i normalizacji plików audio, zapewniając bardziej spójny dźwięk na różnych częstotliwościach.

Co to jest zakres dynamiczny?

Zakres dynamiki definiuje się jako różnicę pomiędzy najcichszymi i najgłośniejszymi częściami pliku audio i odgrywa kluczową rolę w produkcji muzycznej, kształtując ogólny efekt i emocje utworu.

Większy zakres dynamiki pomaga stworzyć wrażenie przestrzeni i głębi w nagraniu, podczas gdy mniejszy zakres dynamiki sprawia, że dźwięk wydaje się bogatszy i bardziej odkrywczy.

Należy znaleźć równowagę pomiędzy utrzymaniem stałego poziomu głośności a utrzymaniem dynamiki materiału audio. Zbyt duża normalizacja lub nadmierna kompresja może spowodować utratę zakresu dynamiki, przez co Twoja muzyka będzie brzmiała płasko i pozbawiona emocji.

Aby zachować dynamikę, ważne jest, aby wybrać metody normalizacji wartości szczytowych i ustawienia, które uwzględniają naturalną dynamikę materiału, zachowując jednocześnie pożądaną głośność (amplitudę szczytową).

Wojna na głośność

We współczesnym przemyśle muzycznym istnieje interesujący trend zwany „wojną głośności”. Termin ten opisuje tendencję do zwiększania ogólnego poziomu głośności nagrań muzycznych w ciągu ostatnich kilku dekad. Uważa się, że głośniejsze utwory mogą przyciągnąć więcej uwagi słuchaczy lub brzmieć lepiej.

Jeśli szukasz najlepszych próbek audio do włączenia do swojej muzyki, ważne jest, aby zapoznać się z najlepszymi darmowymi pakietami sampli na rok 2023. Dzięki temu będziesz mógł wybrać elementy dźwiękowe najbardziej odpowiednie dla Twojej kreatywności.

Zwiększanie głośności nagrań audio ma jednak swoje negatywne konsekwencje. Może to skutkować utratą zakresu dynamiki i gorszą jakością dźwięku muzyki. Wielu artystów, producentów dźwięku i słuchaczy przeciwstawia się temu trendowi, wzywając do bardziej dynamicznych i naturalnych nagrań dźwiękowych.

Biorąc pod uwagę te obawy, wiele usług przesyłania strumieniowego, takich jak Spotify i Apple Music, zaczęło wdrażać normalizację głośności. Pozwala to zachować stałą jakość dźwięku podczas słuchania i zmniejsza potrzebę nadmiernej głośności podczas tworzenia muzyki. Ta zmiana kładzie nacisk na zachowanie zakresu dynamiki i przedkładanie jakości dźwięku nad głośność.

Normalizacja a kompresja: jaka jest różnica?

Wiele osób błędnie uważa, że normalizacja i kompresja to to samo, ale jest to dalekie od prawdy. Kompresja ma na celu podniesienie minimalnego poziomu głośności ścieżki i obniżenie maksymalnego poziomu głośności, tworząc bardziej równomierny ogólny poziom głośności. Natomiast normalizacja ustawia najwyższy punkt jako szczyt ścieżki audio.

Następnie na resztę dźwięku zostaje zastosowane proporcjonalne wzmocnienie, zachowując dynamikę, czyli różnicę pomiędzy dźwiękami najgłośniejszymi i najcichszymi. To skutecznie zwiększa odczuwalną głośność w oparciu o poziom szczytowy, przy jednoczesnym zachowaniu naturalnej jakości dźwięku.

Wady normalizacji dźwięku

Należy pamiętać, że normalizacja dźwięku ma swoje wady. Zwykle stosuje się go dopiero na ostatnich etapach tworzenia materiału audio. Dzieje się tak, ponieważ normalizacja często podnosi poziom dźwięku do wartości szczytowej mieszczącej się w granicach cyfrowych, ograniczając późniejsze możliwości edycji.

Nie zaleca się normalizowania poszczególnych ścieżek audio, które nie zostały jeszcze zmiksowane, w kontekście nagrania wielościeżkowego. Jeśli każdy komponent jest już ustawiony na poziomie cyfrowego sufitu, podczas wspólnego odtwarzania mogą zacząć się przycinać.

Ponadto normalizacja dźwięku może mieć szkodliwe konsekwencje. Kiedy normalizujesz dźwięk, cyfrowe przetwarzanie jest włączane do ścieżki audio, dzięki czemu zmiany są trwałe. Dlatego ważne jest, aby zastosować normalizację w odpowiednim kontekście i we właściwym czasie – zwykle po tym, jak pliki audio zostaną już przetworzone zgodnie z oczekiwaniami.