Normalisation audio

Au cours des trois dernières décennies, la manière dont nous accédons à la musique a subi des changements radicaux. Avec l’avènement des services de streaming numérique et de la technologie de traitement du signal numérique (DSP), la normalisation audio standard est devenue partie intégrante de ce processus.

Mais que signifie la normalisation audio et comment pouvez-vous procéder avec vos propres fichiers audio numériques ? Voyons ce qu'est la normalisation du son et pourquoi elle constitue une étape clé de la créativité musicale moderne.

Le séquenceur en ligne Amped Studio dispose d'une liste complète de fonctionnalités pour une normalisation audio complète, qui vous permet de traiter vos pistes de manière professionnelle.

Qu’est-ce que la normalisation audio ?

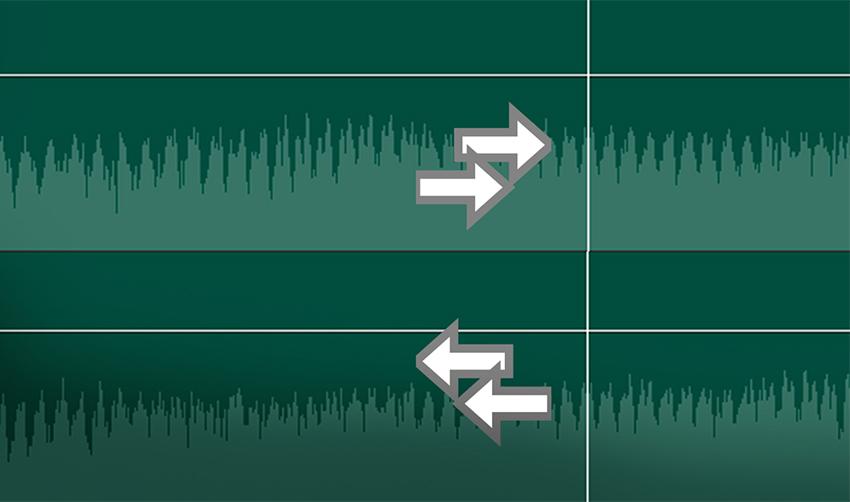

Au cours du processus de normalisation audio, vous appliquez un gain spécifique à un fichier audio numérique, ce qui l'amène à une amplitude ou un niveau de volume spécifique tout en conservant la plage dynamique des pistes.

La normalisation audio est souvent utilisée pour maximiser le volume d'un clip audio sélectionné et garantir la cohérence entre les différents clips audio, comme dans un album ou un EP contenant plusieurs pistes.

Il est important de noter que les compositions avec une large plage dynamique peuvent être plus difficiles à normaliser efficacement. Des problèmes tels qu'un aplatissement ou une distorsion de l'amplitude maximale peuvent survenir pendant le processus de normalisation.

Par conséquent, chaque clip audio nécessite une approche individuelle lors de la normalisation. La normalisation audio fait partie intégrante du traitement de l’enregistrement numérique, mais il n’existe pas d’approche universelle du processus.

Avant et après la normalisation audio

Pourquoi avez-vous besoin de normaliser le son ?

Pourquoi est-il si important de normaliser les fichiers audio ? Voici quelques scénarios dans lesquels la normalisation du volume est indispensable :

Se préparer à travailler avec les services de streaming

Les services de streaming définissent automatiquement un niveau de volume standard pour toutes les pistes de leurs bibliothèques, évitant ainsi d'avoir à régler le volume pendant que vous écoutez. Chaque plateforme possède ses propres LUF cibles pour garantir un son cohérent :

- • Spotify : -14 LUFS ;

- • Apple Music : -16 LUFS ;

- • Amazon Music : de -9 à -13 LUFS ;

- • Youtube : de -13 à -15 LUFS ;

- • Deezer : de -14 à -16 LUFS ;

- • CD : -9 LUFS ;

- • Soundcloud : de -8 à -13 LUFS.

Même si chaque ingénieur du son peut avoir une approche différente pour déterminer le niveau de volume cible pour le mastering, ces normes constituent des lignes directrices importantes pour garantir une lecture musicale cohérente sur toutes les plateformes.

Atteindre le volume maximum

L'utilisation de la normalisation audio vous aide à atteindre le niveau de volume maximum pour chaque fichier audio. Ceci est particulièrement utile lors de l'importation de pistes dans des programmes d'édition audio ou pour augmenter le volume d'un fichier audio individuel.

Création d'une seule couche entre plusieurs fichiers audio

Il est également possible de conditionner les fichiers audio au même niveau de volume, ce qui est important pour des processus tels que le mastering où il est nécessaire de définir des niveaux audio appropriés pour un traitement ultérieur.

De plus, après avoir terminé un projet musical tel qu'un album ou un EP, vous pouvez normaliser et éditer les fichiers audio. Parce que vous souhaitez que l'ambiance et le son de l'ensemble de l'enregistrement soient cohérents, vous devrez peut-être revenir en arrière et ajuster les niveaux de volume pour les adapter à toutes les chansons.

Deux types de normalisation du son

À différentes fins d'utilisation des enregistrements audio, différentes méthodes de normalisation du son sont utilisées. Cela se résume généralement à deux types principaux : la normalisation des crêtes et la normalisation du volume.

Normalisation du pic

Le processus de normalisation des pics est une méthode linéaire dans laquelle une augmentation uniforme est appliquée au signal audio pour atteindre un niveau correspondant à l'amplitude maximale de la piste audio. La plage dynamique reste la même et le nouveau fichier audio sonne à peu près de la même manière, sauf que le niveau de volume peut être supérieur ou inférieur. Ce processus détermine la valeur PCM ou la valeur de modulation de code d'impulsion la plus élevée dans un fichier audio. L'essence de la normalisation des pics consiste à traiter l'audio en fonction de la limite supérieure d'un système audio numérique, qui correspond généralement à un pic maximum à 0 décibels. L'effet de normalisation des pics est basé uniquement sur les niveaux audio de pointe et non sur le volume perçu de la piste.

Normalisation des volumes

Le processus de normalisation de l’intensité sonore est plus complexe car il prend en compte les caractéristiques de la perception sonore humaine. L'oreille humaine est capable de distinguer différents niveaux de volume et d'amplitude de sons individuels, sous réserve de certaines limitations subjectives. Ce traitement est souvent appelé détermination de l'intensité sonore EBU R 128.

Par exemple, les sons joués pendant une longue période au même niveau de volume peuvent sembler plus forts que les sons joués par intermittence ou momentanément, même si les niveaux de volume sont les mêmes. Cela est dû à la façon dont l’oreille humaine perçoit le son. Par conséquent, lors de la normalisation du volume sonore, il est nécessaire de prendre en compte ces caractéristiques perceptuelles.

Certaines personnes trouvent qu’une musique plus forte semble plus attrayante. C’est cette notion qui a donné naissance aux « guerres du volume sonore » avant l’avènement des services de streaming, les musiciens cherchant à maximiser le volume de pointe de leurs enregistrements pour créer un son plus proéminent et plus coloré. Cependant, grâce à la normalisation du son, ce phénomène appartient au passé, et désormais la transition entre les pistes ne s'accompagne plus de changements brusques de volume.

Les LUF sont utilisés pour mesurer les niveaux sonores afin de mieux correspondre à la perception humaine du son. Cette norme est largement utilisée dans les services de cinéma, de télévision, de radio et de streaming. Comme pour la normalisation des crêtes, 0 dB reste la norme.

La courbe de Fletcher-Munson, comme indiqué ci-dessus, peut aider à expliquer les différences prises en compte lors de la normalisation de l'intensité sonore dans les LUF.

Les normes de volume varient selon la région et l'application

- 24 LUFS : ATSC A/85 (télévision américaine), NPRSS, émission radio PRX ;

- 23 LUFS : traduction de l'EBU R 128 ;

- -19 à -16 LUFS : podcasts PRX ;

- 14 LUFS : Spotify, YouTube et autres plateformes de streaming.

Détermination du volume carré moyen

Si vous n'avez pas l'intention de normaliser les canaux stéréo à l'aide de la normalisation du niveau de crête, vous utiliserez probablement la normalisation de l'intensité sonore, mais il convient également de mentionner une autre technique de traitement de l'intensité sonore, l'intensité sonore RMS.

Le processus de normalisation est similaire à la normalisation de l'intensité sonore dans les LUF, mais les niveaux RMS sont utilisés à la place. Root Mean Square (RMS) mesure le volume moyen d'une section ou la durée totale d'un clip.

Cependant, tout comme la normalisation basée sur le pic le plus élevé, la normalisation RMS ne prend pas en compte l’audition humaine. C'est pourquoi les ingénieurs de mastering travaillent généralement avec les LUF et les processus de normalisation comme standard. Le mastering ne consiste pas seulement à s'assurer que les volumes sont cohérents tout au long du projet. Il est également important de prendre du recul et de considérer la dynamique, la perception humaine et l'équilibre entre chaque morceau.

Quand utiliser la normalisation

Maintenant que vous comprenez ce qu'est la normalisation audio, voyons quand et comment l'utiliser.

Maîtriser votre musique

La normalisation audio est un outil clé dans le processus de mastering des pistes.

Lors du mastering, il est important de maintenir un niveau de volume constant sur vos morceaux.

Cela permet à vos auditeurs de profiter de leur musique sans avoir à régler constamment le volume.

En normalisant vos pistes, par exemple lors de la création d'un post-mix/master pour votre album, vous pouvez obtenir un son professionnel et soigné.

Celui qui répond aux normes de diffusion commerciale et est prêt à être distribué.

En parlant de mastering, si vous recherchez les meilleurs plugins de mastering, nous sommes là pour vous aider à les trouver.

Préparation aux services de streaming

Les services de streaming ont des exigences de volume spécifiques qui doivent être prises en compte lors du téléchargement de musique.

La normalisation peut vous aider à répondre à ces exigences, en offrant une excellente qualité audio sur ces plateformes.

En normalisant les fichiers pour qu'ils correspondent au niveau cible du service de streaming, vous garantissez une qualité de lecture constante pour vos fans.

Cependant, si vous ne suivez pas ce processus vous-même, les services de streaming peuvent le faire à votre place en utilisant la compression, la limitation et d'autres techniques.

Cela peut entraîner de graves problèmes de qualité audio.

N'oubliez pas de vérifier les recommandations de volume pour chaque service de streaming spécifique, car les exigences peuvent varier.

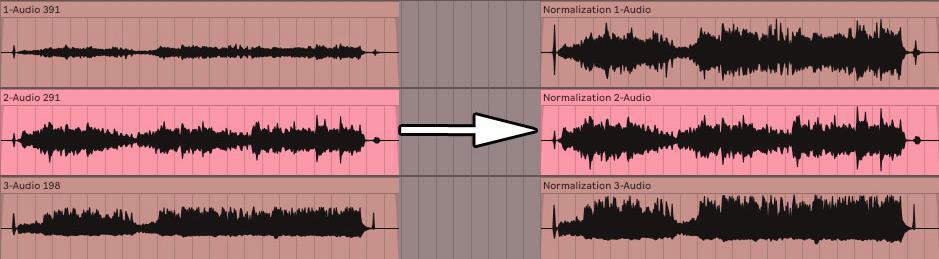

Travailler avec divers fichiers audio

Lorsque vous travaillez avec plusieurs fichiers audio dans un projet, il est important de conserver le même niveau de volume pour tous.

Ceci est particulièrement important si les fichiers audio proviennent de sources différentes ou sont enregistrés à des volumes différents.

Ceci est particulièrement important si les fichiers audio proviennent de sources différentes ou sont enregistrés à des volumes différents.

Ceci est particulièrement important si les fichiers audio proviennent de sources différentes ou sont enregistrés à des volumes différents.

Idées fausses courantes sur la normalisation audio

Je pense qu'il est très important de considérer certaines idées fausses courantes avant d'aller de l'avant, surtout pour ceux qui débutent.

1. La normalisation et la compression du son sont deux choses différentes

Certaines personnes confondent normalisation et compression, mais elles ont des objectifs complètement différents.

Alors que la normalisation ajuste le niveau de volume global d'un fichier audio, la compression réduit la plage dynamique du fichier.

La compression peut aider à créer un niveau de volume plus stable dans un fichier audio, mais elle n'augmente pas nécessairement le niveau de volume global du nouveau fichier audio.

À moins que ce ne soit votre objectif, bien sûr.

La compression est généralement utilisée pour la correction dynamique et l'amélioration du son, tandis que la normalisation est davantage une fonction utilitaire.

Si vous recherchez les meilleurs plugins de compression pour ce processus, ne cherchez pas plus loin.

2. La normalisation du son ne résout pas tout

Il est important de rappeler que la normalisation des pics ne résout pas tous les problèmes audio.

Si vous rencontrez des problèmes de rapport signal/bruit, de distorsion ou d'autres artefacts audio, la normalisation à elle seule ne résoudra pas ces problèmes.

Dans de tels cas, vous devez vous attaquer aux causes profondes du problème et utiliser d’autres techniques de traitement audio telles que l’égaliseur ou la réduction du bruit pour obtenir le son souhaité.

Si une telle situation se présente, nous avons les meilleurs plugins d’égalisation de 2023.

3. La normalisation du son n'augmente pas les réserves de puissance

Lors de la normalisation des fichiers audio, il est important de maintenir une marge de volume suffisante dans vos mixages et enregistrements.

La marge est la différence entre le point le plus fort de votre fichier audio et le niveau de volume maximum que votre système audio numérique peut gérer.

Si vous normalisez votre audio de manière trop agressive, vous risquez une distorsion et un écrêtage, ce qui peut avoir un impact négatif sur la qualité de votre musique.

N'oubliez pas que quel que soit le DAW ou le système que vous utilisez, il est important de surveiller tout ce qui dépasse la barre des 0 dB.

En effet, éviter la restriction et disposer d’une marge suffisante évite les distorsions.

Par exemple, j'aime considérer -16 dB comme objectif de marge, et pour tout ce qui dépasse ce chiffre, j'utilise un limiteur (juste pour maintenir une marge adéquate).

Cela permet également de compenser les changements de volume nécessaires pendant la phase de mastering.

Processus de normalisation du son

Maintenant que nous avons abordé les idées fausses les plus courantes sur la normalisation audio, approfondissons le processus lui-même.

Analysez vos fichiers audio

Avant de normaliser les fichiers audio, il est important de les analyser et de déterminer les niveaux de volume actuels.

Cette analyse peut être effectuée à l'aide d'outils intégrés à votre DAW ou à l'aide d'un logiciel d'analyse audio dédié.

En comprenant les niveaux de volume actuels de vos fichiers, vous pouvez prendre des décisions éclairées concernant le processus de normalisation audio.

Sélection d'une cible de normalisation audio

Après avoir analysé les fichiers, vous pouvez choisir la cible de normalisation qui correspond le mieux à vos besoins.

Les facteurs à prendre en compte lors du choix d’une méthode de normalisation comprennent :

- Type de matériel audio ;

- Niveau de volume souhaité ;

- Type de traitement effectué ;

- Plateforme de destination pour votre musique.

Chaque niveau de normalisation a ses propres forces et faiblesses, il est donc important de choisir celui qui fournira les meilleurs résultats pour votre situation spécifique.

- Dans des situations de mixage . Restez dans la fourchette basse à deux chiffres, idéalement -18 à -12 dB ;

- À des fins de mastering . Une option sûre serait n'importe quelle valeur comprise entre -8 et -3 dB.

Dans certains services et situations de streaming, il peut y avoir une situation où -0 dB est garanti, alors assurez-vous simplement qu'il ne dépasse pas cette valeur car elle se situe juste à la limite de la limite.

Note. Pendant le processus de mixage, il est important de prêter une attention particulière aux paramètres de gain ainsi qu'à la détermination du volume RMS afin de déterminer la quantité de gain nécessaire pour chaque piste.

L'utilisation du contrôle de gain du clip peut vous aider à obtenir un contrôle précis des niveaux de volume, garantissant ainsi un mixage bien équilibré.

Normalisation du son

Après avoir sélectionné la cible de normalisation appropriée, vous pouvez éditer les fichiers audio à l'aide d'un DAW ou d'un logiciel d'édition audio dédié.

La plupart des DAW et des logiciels d'édition audio disposent d'outils de normalisation intégrés qui les rendent faciles à utiliser.

En règle générale, cela est aussi simple que de mettre en surbrillance l'audio et d'appuyer sur la commande, ou simplement de sélectionner « Normaliser » dans le menu déroulant.

Assurez-vous de surveiller les résultats du processus de normalisation pour vous assurer que les nouveaux niveaux de volume répondent à vos attentes et ne provoquent pas d'artefacts ou de problèmes indésirables.

Compression vs normalisation

Lorsqu'il s'agit de normalisation, elle est le plus souvent comparée au processus de compression. Comprendre les différences et choisir la bonne méthode de traitement audio sont des compétences clés pour un producteur de musique, alors examinons cela de plus près.

La compression et la normalisation sont deux techniques de traitement audio distinctes, chacune ayant ses propres objectifs.

- La normalisation vise à ajuster le niveau de volume global d'un fichier audio ;

- La compression, à son tour, réduit la plage dynamique du fichier.

Il est important de se rappeler que la compression rend les parties les plus silencieuses d'un fichier audio plus fortes et les parties les plus fortes plus silencieuses. Bien que les deux méthodes puissent être utilisées pour obtenir un niveau de volume plus cohérent, elles affectent le son différemment et peuvent avoir des effets différents sur votre matériel.

Oui, la compression peut rendre le son plus fort, mais son objectif principal est autre chose.

Quand utiliser la compression

La normalisation est un processus utile lorsque vous devez égaliser le niveau de volume global d'un fichier audio ou d'un groupe de fichiers. Comme nous l'avons mentionné précédemment, cela est particulièrement utile lors du mastering de votre piste audio ou de la préparation de musique pour les services de streaming. Contrairement à la compression, la normalisation n'affecte pas la plage dynamique d'un fichier audio, ce qui en fait une méthode de traitement plus transparente et moins intrusive. De plus, cela n’implique pas non plus d’objectifs, de significations ou de propriétés dynamiques, correctifs ou améliorants.

Quand utiliser la normalisation du volume

La normalisation est un outil qui doit être utilisé lorsque vous souhaitez égaliser le niveau de volume global d'un fichier audio ou d'un groupe de fichiers. Comme indiqué précédemment, cela est particulièrement important lors du mastering de votre piste audio ou de la préparation de musique pour les services de streaming. Contrairement à la compression, la normalisation ne modifie pas la plage dynamique du fichier audio, le rendant plus neutre et moins intrusif dans le son. De plus, il n’est pas destiné à corriger ou améliorer les caractéristiques dynamiques d’un fichier audio.

Dynamique et oreille humaine

Le système auditif humain est un mécanisme complexe qui réagit à une variété de fréquences et de niveaux de volume. Notre perception du son est non linéaire : les changements de niveaux de volume et de fréquences sont perçus différemment.

Il est important de prendre en compte cette nature non linéaire de la perception lors de la normalisation des fichiers audio, car elle peut affecter la manière dont les auditeurs perçoivent la musique.

Les courbes d'intensité sonore égale, ou courbes de Fletcher-Munson, décrivent comment l'oreille humaine réagit à l'intensité sonore à différentes fréquences. Ils montrent que l’audition est plus sensible à certaines gammes de fréquences, notamment de 2 à 5 kHz, et moins sensible aux très basses et hautes fréquences.

Connaître ces courbes peut aider à prendre des décisions éclairées sur la perception humaine et lors de la normalisation des fichiers audio, en fournissant un son plus cohérent sur différentes fréquences.

Qu’est-ce que la plage dynamique ?

La plage dynamique est définie comme la différence entre les parties les plus silencieuses et les plus fortes d'un fichier audio et joue un rôle clé dans la production musicale, façonnant l'impact global et l'émotion d'un morceau.

Une plage dynamique plus large contribue à créer une impression d'espace et de profondeur dans l'enregistrement, tandis qu'une plage dynamique plus petite rend le son plus riche et plus révélateur.

Il y a un équilibre à trouver entre maintenir un niveau de volume constant et maintenir la dynamique de votre matériel audio. Une normalisation ou une compression excessive peut entraîner une perte de plage dynamique, rendant votre musique plate et manquant d'émotion.

Pour conserver la dynamique, il est important de choisir des méthodes et des réglages de normalisation des crêtes qui respectent la dynamique naturelle de votre matériel tout en conservant le volume sonore souhaité (amplitude de crête).

Guerre du volume

Il existe une tendance intéressante dans l’industrie musicale moderne appelée « guerre du volume ». Ce terme décrit la tendance à l’augmentation des volumes globaux de musique enregistrée au cours des dernières décennies. On pense que les chansons plus fortes peuvent attirer davantage l'attention des auditeurs ou avoir un meilleur son.

Si vous recherchez les meilleurs échantillons audio à intégrer dans votre musique, il est important de jeter un œil aux meilleurs packs d'échantillons gratuits de 2023. Cela vous permettra de sélectionner les éléments sonores les plus adaptés à votre créativité.

Cependant, augmenter le volume des enregistrements audio a des conséquences négatives. Cela peut entraîner une perte de plage dynamique et une mauvaise qualité sonore de la musique. De nombreux artistes, producteurs de son et auditeurs s’opposent à cette tendance et réclament des enregistrements sonores plus dynamiques et plus naturels.

Compte tenu de ces préoccupations, de nombreux services de streaming tels que Spotify et Apple Music ont commencé à mettre en œuvre une normalisation du volume. Cela vous permet de maintenir une qualité sonore constante pendant l'écoute et réduit le besoin d'un volume excessif lors de la création de musique. Ce changement met l’accent sur la préservation de la plage dynamique et la priorité à la qualité sonore plutôt qu’au volume.

Normalisation vs compression : quelle est la différence ?

Beaucoup de gens croient à tort que la normalisation et la compression sont une seule et même chose, mais c’est loin d’être vrai. La compression vise à augmenter le niveau de volume minimum d'une piste et à abaisser le niveau de volume maximum, créant ainsi un niveau de volume global plus uniforme. En revanche, la normalisation définit le point le plus élevé comme sommet de la piste audio.

Une amplification proportionnelle est ensuite appliquée au reste du son, conservant la dynamique, c'est-à-dire la différence entre les sons les plus forts et les plus faibles. Cela augmente efficacement le volume perçu en fonction du niveau de crête tout en conservant une qualité sonore naturelle.

Inconvénients de la normalisation audio

Il est important de noter que la normalisation audio présente des inconvénients. Habituellement, il n'est utilisé qu'aux dernières étapes de la création de matériel audio. En effet, la normalisation pousse souvent le niveau audio à un sommet dans la limite numérique, limitant ainsi les options d'édition ultérieures.

Il n'est pas conseillé de normaliser des pistes audio individuelles qui doivent encore être mixées dans le contexte d'un enregistrement multipiste. Si chaque composant est déjà aligné sur le plafond numérique, ils peuvent commencer à s'écrêter lorsqu'ils sont lus ensemble.

De plus, la normalisation audio peut avoir des conséquences néfastes. Lorsque vous normalisez l'audio, le traitement numérique est intégré à la piste audio, rendant les modifications permanentes. Il est donc important d’appliquer la normalisation dans le bon contexte et au bon moment – généralement après que les fichiers audio ont déjà été traités comme souhaité.

Inscrivez-vous gratuitement et obtenez un projet gratuitement