Normalizzazione dell'audio

Negli ultimi tre decenni, il modo in cui accediamo alla musica ha subito cambiamenti radicali. Con l'avvento dei servizi di streaming digitale e della tecnologia di elaborazione del segnale digitale (DSP), la normalizzazione audio standard è diventata parte integrante di questo processo.

Ma cosa significa normalizzazione audio e come puoi eseguire questo processo con i tuoi file audio digitali? Diamo un'occhiata a cos'è la normalizzazione del suono e perché è una fase chiave nella creatività musicale moderna.

Il sequencer online Amped Studio dispone di un elenco completo di funzionalità per la normalizzazione audio completa, che ti consente di elaborare le tue tracce in modo professionale.

Cos'è la normalizzazione audio?

Durante il processo di normalizzazione dell'audio, si applica un guadagno specifico a un file audio digitale, che lo porta a un livello di ampiezza o volume specifico mantenendo la gamma dinamica delle tracce.

La normalizzazione audio viene spesso utilizzata per massimizzare il volume di una clip audio selezionata e garantire la coerenza tra le diverse clip audio, come in un album o un EP che contiene più tracce.

È importante notare che le composizioni con un'ampia gamma dinamica possono essere più difficili da normalizzare in modo efficace. Durante il processo di normalizzazione possono verificarsi problemi come l'appiattimento o la distorsione dell'ampiezza del picco.

Pertanto, ogni clip audio richiede un approccio individuale durante la normalizzazione. La normalizzazione dell'audio è parte integrante dell'elaborazione della registrazione digitale, ma non esiste un approccio unico al processo.

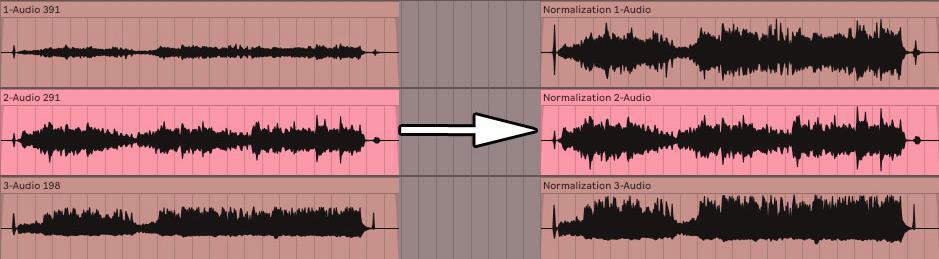

Prima e dopo la normalizzazione dell'audio

Perché è necessario normalizzare il suono?

Perché è così importante normalizzare i file audio? Ecco alcuni scenari in cui la normalizzazione del volume è indispensabile:

Preparazione per lavorare con i servizi di streaming

I servizi di streaming impostano automaticamente un livello di volume standard per tutte le tracce nelle loro librerie, evitando la necessità di regolare il volume durante l'ascolto. Ogni piattaforma ha i propri LUF target per garantire un suono coerente:

- • Spotify : -14 LUFS;

- • Apple Musica : -16 LUFS;

- • Amazon Music : da -9 a -13 LUFS;

- • Youtube : da -13 a -15 LUFS;

- • Deezer : da -14 a -16 LUFS;

- • CD : -9 LUFS;

- • Soundcloud : da -8 a -13 LUFS.

Sebbene ogni tecnico del suono possa avere un approccio diverso nel determinare il livello di volume target per la masterizzazione, questi standard sono linee guida importanti per garantire una riproduzione musicale coerente su tutte le piattaforme.

Raggiungere il volume massimo

L'uso della normalizzazione audio ti aiuta a raggiungere il livello di volume massimo per ciascun file audio. Ciò è particolarmente utile quando si importano tracce in programmi di editing audio o per aumentare il volume di un singolo file audio.

Creazione di un singolo livello tra più file audio

È anche possibile condizionare i file audio allo stesso livello di volume, il che è importante per processi come il mastering dove è necessario impostare livelli audio appropriati per l'elaborazione successiva.

Inoltre, dopo aver completato un progetto musicale come un album o un EP, puoi normalizzare e modificare i file audio. Poiché desideri che l'atmosfera e il suono dell'intera registrazione siano coerenti, potrebbe essere necessario tornare indietro e regolare i livelli del volume per adattarli a tutti i brani.

Due tipi di normalizzazione del suono

Per diversi scopi di utilizzo delle registrazioni audio, vengono utilizzati diversi metodi di normalizzazione del suono. Questo di solito si riduce a due tipi principali: normalizzazione del picco e normalizzazione del volume.

Normalizzazione del picco

Il processo di normalizzazione del picco è un metodo lineare in cui viene applicato un aumento uniforme al segnale audio per raggiungere un livello corrispondente all'ampiezza massima della traccia audio. La gamma dinamica rimane la stessa e il nuovo file audio suona più o meno allo stesso modo, tranne per il fatto che il livello del volume potrebbe essere più alto o più basso. Questo processo determina il valore PCM o il valore di modulazione del codice di impulso più alto in un file audio. L'essenza della normalizzazione del picco è elaborare l'audio in base al limite superiore di un sistema audio digitale, che in genere corrisponde a un picco massimo a 0 decibel. L'effetto di normalizzazione del picco si basa esclusivamente sui livelli audio di picco e non sul volume percepito della traccia.

Normalizzazione del volume

Il processo di normalizzazione del volume è più complesso perché tiene conto delle caratteristiche della percezione del suono umano. L'orecchio umano è in grado di distinguere diversi livelli di volume e ampiezza dei singoli suoni, soggetti ad alcune limitazioni soggettive. Questa elaborazione viene spesso definita determinazione del volume EBU R 128.

Ad esempio, i suoni riprodotti per un lungo periodo allo stesso livello di volume potrebbero sembrare più forti dei suoni riprodotti in modo intermittente o momentaneo, anche se i livelli di volume sono gli stessi. Ciò si verifica a causa del modo in cui l'orecchio umano percepisce il suono. Pertanto, quando si normalizza il volume, è necessario tenere conto di queste caratteristiche percettive.

Alcune persone trovano che la musica ad alto volume risulti più attraente. È stata questa idea a dare vita alle “guerre del volume” prima dell’avvento dei servizi di streaming, con i musicisti che cercavano di massimizzare il volume di picco delle loro registrazioni per creare un suono più prominente e colorato. Tuttavia, grazie alla normalizzazione del suono, questo fenomeno appartiene al passato e ora la transizione tra i brani non è accompagnata da improvvisi cambiamenti di volume.

I LUF vengono utilizzati per misurare i livelli di volume per corrispondere più fedelmente alla percezione umana del suono. Questo standard è ampiamente utilizzato nei servizi cinematografici, televisivi, radiofonici e di streaming. Come per la normalizzazione del picco, 0 dB rimane lo standard.

La curva Fletcher-Munson, come affermato sopra, può aiutare a spiegare le differenze prese in considerazione durante la normalizzazione del volume nei LUF.

Gli standard di volume variano in base alla regione e all'applicazione

- 24 LUFS: ATSC A/85 (televisione americana), NPRSS, trasmissione radiofonica PRX;

- 23 LUFS: traduzione EBU R 128;

- Da -19 a -16 LUFS: podcast PRX;

- 14 LUFS: Spotify, YouTube e altre piattaforme di streaming.

Determinazione del volume quadratico medio

Se non intendi normalizzare i canali stereo utilizzando la normalizzazione del livello di picco, probabilmente utilizzerai la normalizzazione del volume, ma vale anche la pena menzionare un'altra tecnica di elaborazione del volume, il volume RMS.

Il processo di normalizzazione è simile alla normalizzazione del volume nei LUF, ma vengono utilizzati invece i livelli RMS. Root Mean Square (RMS) misura il volume medio di una sezione o dell'intera durata di una clip.

Tuttavia, proprio come la normalizzazione basata sul picco più alto, la normalizzazione RMS non tiene conto dell’udito umano. Questo è il motivo per cui gli ingegneri di mastering in genere lavorano con LUF e processi di normalizzazione come standard. Il mastering non significa solo assicurarsi che i volumi siano coerenti durante l'intero progetto. È anche importante fare un passo indietro e considerare le dinamiche, la percezione umana e l'equilibrio tra ogni traccia.

Quando utilizzare la normalizzazione

Ora che hai capito cos'è la normalizzazione audio, discutiamo quando e come dovrebbe essere utilizzata.

Padroneggiare la tua musica

La normalizzazione dell'audio è uno strumento chiave nel processo di mastering della traccia.

Durante la masterizzazione, è importante mantenere un livello di volume costante sulle tracce.

Ciò consente ai tuoi ascoltatori di godersi la musica senza dover regolare costantemente il volume.

Normalizzando le tue tracce, ad esempio quando crei un post-mix/master per il tuo album, puoi ottenere un suono professionale e raffinato.

Uno che soddisfi gli standard di rilascio commerciale ed è pronto per la distribuzione.

A proposito di mastering, se stai cercando i migliori plugin per il mastering, siamo qui per aiutarti a trovarli.

Preparazione per i servizi di streaming

I servizi di streaming hanno requisiti di volume specifici che devono essere presi in considerazione quando si scarica musica.

La normalizzazione può aiutarti a soddisfare questi requisiti, fornendo un'eccellente qualità audio su queste piattaforme.

Normalizzando i file in modo che corrispondano al livello target del servizio di streaming, garantisci una qualità di riproduzione coerente per i tuoi fan.

Tuttavia, se non esegui tu stesso questo processo, i servizi di streaming possono farlo per te utilizzando compressione, limitazione e altre tecniche.

Ciò può portare a seri problemi con la qualità audio.

Ricorda sempre di controllare i consigli sul volume per ciascun servizio di streaming specifico, poiché i requisiti possono variare.

Lavorare con vari file audio

Quando si lavora con più file audio in un progetto, è importante mantenere il livello del volume lo stesso per tutti.

Ciò è particolarmente importante se i file audio provengono da fonti diverse o sono registrati a volumi diversi.

Ciò è particolarmente importante se i file audio provengono da fonti diverse o sono registrati a volumi diversi.

Ciò è particolarmente importante se i file audio provengono da fonti diverse o sono registrati a volumi diversi.

Idee sbagliate comuni sulla normalizzazione dell'audio

Penso che sia molto importante considerare alcuni malintesi comuni prima di andare avanti, soprattutto per chi ha appena iniziato.

1. La normalizzazione e la compressione del suono sono due cose diverse

Alcune persone confondono normalizzazione e compressione, ma hanno scopi completamente diversi.

Mentre la normalizzazione regola il livello del volume generale di un file audio, la compressione riduce la gamma dinamica del file.

La compressione può contribuire a creare un livello di volume più stabile all'interno di un file audio, ma non aumenta necessariamente il livello di volume complessivo del nuovo file audio.

A meno che non sia questo il tuo obiettivo, ovviamente.

La compressione viene generalmente utilizzata per la correzione dinamica e il miglioramento del suono, mentre la normalizzazione è più una funzione utilitaristica.

Se stai cercando i migliori plugin di compressione per questo processo, non cercare oltre.

2. La normalizzazione del suono non risolve tutto

È importante ricordare che la normalizzazione dei picchi non risolve tutti i problemi audio.

Se riscontri problemi con il rapporto segnale-rumore, distorsione o altri artefatti audio, la sola normalizzazione non risolverà tali problemi.

In questi casi, è necessario affrontare le cause profonde del problema e utilizzare altre tecniche di elaborazione audio come l'equalizzatore o la riduzione del rumore per ottenere il suono desiderato.

Se si verifica una situazione del genere, abbiamo i migliori plugin per equalizzatore del 2023.

3. La normalizzazione del suono non aumenta le riserve di potenza

Quando si normalizzano i file audio, è importante mantenere un margine di volume sufficiente nei mix e nelle registrazioni.

L'headroom è la differenza tra il punto più forte del file audio e il livello di volume massimo che il tuo sistema audio digitale può gestire.

Se normalizzi l'audio in modo troppo aggressivo, rischi di distorsioni e clip, che possono avere un impatto negativo sulla qualità della tua musica.

Ricorda che non importa quale DAW o sistema usi, è importante monitorare qualsiasi cosa al di sopra del segno 0 dB.

Questo perché evitare la restrizione e avere un margine sufficiente evita distorsioni.

Ad esempio, mi piace considerare -16dB come obiettivo per l'headroom e per valori superiori utilizzo un limitatore (solo per mantenere un headroom adeguato).

Ciò aiuta anche a compensare eventuali modifiche di volume necessarie durante la fase di mastering.

Processo di normalizzazione del suono

Ora che abbiamo coperto le idee sbagliate più comuni sulla normalizzazione dell'audio, approfondiamo il processo stesso.

Analizza i tuoi file audio

Prima di normalizzare i file audio, è importante analizzarli e determinare i livelli di volume attuali.

Questa analisi può essere eseguita utilizzando gli strumenti integrati nella DAW o utilizzando un software di analisi audio dedicato.

Comprendendo i livelli di volume attuali dei tuoi file, puoi prendere decisioni informate sul processo di normalizzazione dell'audio.

Selezione di un obiettivo di normalizzazione audio

Dopo aver analizzato i file, puoi scegliere l'obiettivo di normalizzazione più adatto alle tue esigenze.

I fattori da considerare quando si sceglie un metodo di normalizzazione includono:

- Tipologia del materiale audio;

- Livello del volume desiderato;

- Tipologia di trattamento effettuato;

- Piattaforma di destinazione per la tua musica.

Ogni livello di normalizzazione ha i suoi punti di forza e di debolezza, quindi è importante scegliere quello che fornirà i migliori risultati per la tua situazione specifica.

- In situazioni di miscelazione . Rimani sui bassi a doppia cifra, idealmente da -18 a -12 dB;

- Per scopi di masterizzazione . Un'opzione sicura sarebbe qualsiasi valore compreso tra -8 e -3 dB.

In alcuni servizi e situazioni di streaming potrebbe esserci una situazione in cui è garantito -0 dB, quindi assicurati solo che non superi questo valore poiché è proprio al limite.

Nota. Durante il processo di mixaggio, è importante prestare molta attenzione alle impostazioni del guadagno e determinare il volume RMS per determinare la quantità di guadagno necessaria per ciascuna traccia.

L'utilizzo del controllo del guadagno della clip può aiutarti a ottenere un controllo preciso sui livelli di volume, garantendo un mix ben bilanciato.

Normalizzazione del suono

Dopo aver selezionato la destinazione di normalizzazione appropriata, è possibile modificare i file audio utilizzando una DAW o un software di editing audio dedicato.

La maggior parte delle DAW e dei software di editing audio dispongono di strumenti di normalizzazione integrati che li rendono facili da usare.

In genere, è semplice come evidenziare l'audio e premere il comando o semplicemente selezionare "Normalizza" dal menu a discesa.

Assicurati di monitorare i risultati del processo di normalizzazione per garantire che i nuovi livelli di volume soddisfino le tue aspettative e non causino artefatti o problemi indesiderati.

Compressione vs Normalizzazione

Quando si parla di normalizzazione, molto spesso viene paragonata al processo di compressione. Comprendere le differenze e scegliere il giusto metodo di elaborazione audio sono competenze chiave per un produttore musicale, quindi diamo un'occhiata più da vicino a questo.

La compressione e la normalizzazione sono due tecniche di elaborazione audio separate, ciascuna con i propri obiettivi unici.

- La normalizzazione ha lo scopo di regolare il livello del volume generale di un file audio;

- La compressione, a sua volta, riduce la gamma dinamica all'interno del file.

È importante ricordare che la compressione rende le parti più silenziose di un file audio più forti e le parti più forti più silenziose. Sebbene entrambi i metodi possano essere utilizzati per ottenere un livello di volume più coerente, influenzano il suono in modo diverso e possono avere effetti diversi sul materiale.

Sì, la compressione può rendere il suono più forte, ma il suo scopo principale è qualcos'altro.

Quando utilizzare la compressione

La normalizzazione è un processo utile quando è necessario equalizzare il livello del volume generale di un file audio o di un gruppo di file. Come abbiamo discusso in precedenza, ciò è particolarmente utile quando si masterizza la traccia audio o si prepara la musica per i servizi di streaming. A differenza della compressione, la normalizzazione non influisce sulla gamma dinamica di un file audio, rendendolo un metodo di elaborazione più trasparente e meno invasivo. Inoltre, non implica alcun obiettivo, significato o proprietà dinamica, correttiva o migliorativa.

Quando utilizzare la normalizzazione del volume

La normalizzazione è uno strumento che dovrebbe essere utilizzato quando si desidera equalizzare il livello del volume generale di un file audio o di un gruppo di file. Come discusso in precedenza, questo è particolarmente importante quando si masterizza la traccia audio o si prepara la musica per i servizi di streaming. A differenza della compressione, la normalizzazione non modifica la gamma dinamica del file audio, rendendolo più neutro e meno invasivo per il suono. Inoltre, non è destinato a correggere o migliorare le caratteristiche dinamiche di un file audio.

Dinamica e orecchio umano

Il sistema uditivo umano è un meccanismo complesso che risponde a una varietà di frequenze e livelli di volume. La nostra percezione del suono non è lineare: i cambiamenti nei livelli di volume e nelle frequenze sono percepiti in modo diverso.

Questa natura non lineare della percezione è importante da considerare quando si normalizzano i file audio, poiché può influenzare il modo in cui gli ascoltatori percepiscono la musica.

Le curve di volume uguale, o curve di Fletcher-Munson, descrivono come l'orecchio umano risponde al volume a frequenze diverse. Mostrano che l'udito è più sensibile a determinate gamme di frequenza, soprattutto da 2 a 5 kHz, e meno sensibile alle frequenze molto basse e alte.

Conoscere queste curve può aiutare a prendere decisioni informate sulla percezione umana e sulla normalizzazione dei file audio, fornendo un audio più coerente su frequenze diverse.

Cos'è la gamma dinamica?

La gamma dinamica è definita come la differenza tra le parti più silenziose e quelle più forti di un file audio e svolge un ruolo chiave nella produzione musicale, modellando l'impatto e l'emozione complessivi di un brano.

Una gamma dinamica più ampia aiuta a creare un senso di spazio e profondità nella registrazione, mentre una gamma dinamica più piccola rende il suono più ricco e rivelatore.

È necessario trovare un equilibrio tra il mantenimento di un livello di volume costante e il mantenimento della dinamica del materiale audio. Troppa normalizzazione o compressione eccessiva possono comportare una perdita di gamma dinamica, rendendo la tua musica piatta e priva di emozione.

Per mantenere la dinamica, è importante scegliere metodi e impostazioni di normalizzazione del picco che rispettino la dinamica naturale del materiale mantenendo il volume desiderato (ampiezza di picco).

Guerra del volume

C’è una tendenza interessante nell’industria musicale moderna chiamata “guerra del volume”. Questo termine descrive la tendenza all’aumento dei livelli di volume complessivi della musica registrata negli ultimi decenni. Si ritiene che le canzoni più forti possano attirare più attenzione degli ascoltatori o suonare meglio.

Se stai cercando i migliori campioni audio da incorporare nella tua musica, è importante dare un'occhiata ai migliori pacchetti di campioni gratuiti del 2023. Ciò ti consentirà di selezionare gli elementi sonori più adatti alla tua creatività.

Tuttavia, aumentare il volume delle registrazioni audio ha le sue conseguenze negative. Ciò potrebbe comportare una perdita di gamma dinamica e una scarsa qualità del suono della musica. Molti artisti, produttori di suoni e ascoltatori si stanno opponendo a questa tendenza, chiedendo registrazioni sonore più dinamiche e naturali.

Date queste preoccupazioni, molti servizi di streaming come Spotify e Apple Music hanno iniziato a implementare la normalizzazione del volume. Ciò consente di mantenere una qualità del suono costante durante l'ascolto e riduce la necessità di un volume eccessivo durante la creazione di musica. Questo cambiamento enfatizza la preservazione della gamma dinamica e la priorità nella qualità del suono rispetto al volume.

Normalizzazione vs compressione: qual è la differenza?

Molte persone credono erroneamente che normalizzazione e compressione siano la stessa cosa, ma questo è tutt’altro che vero. La compressione mira ad aumentare il livello di volume minimo di una traccia e ad abbassare il livello di volume massimo, creando un livello di volume complessivo più uniforme. Al contrario, la normalizzazione imposta il punto più alto come picco della traccia audio.

Al resto del suono viene quindi applicata un'amplificazione proporzionale, mantenendo la dinamica, ovvero la differenza tra i suoni più forti e quelli più deboli. Ciò aumenta efficacemente il volume percepito in base al livello di picco mantenendo la qualità del suono naturale.

Svantaggi della normalizzazione audio

È importante notare che la normalizzazione dell'audio ha i suoi svantaggi. Di solito viene utilizzato solo nelle ultime fasi della creazione di materiale audio. Questo perché la normalizzazione spesso spinge il livello audio a un picco entro il limite digitale, limitando le successive opzioni di modifica.

Non è consigliabile normalizzare le singole tracce audio che devono ancora essere mixate nel contesto di una registrazione multitraccia. Se ciascun componente è già al livello del soffitto digitale, potrebbero iniziare a clippare quando vengono riprodotti insieme.

Inoltre, la normalizzazione dell'audio può avere alcune conseguenze dannose. Quando normalizzi l'audio, l'elaborazione digitale viene integrata nella traccia audio, rendendo le modifiche permanenti. Pertanto, è importante applicare la normalizzazione nel giusto contesto e al momento giusto, solitamente dopo che i file audio sono già stati elaborati come desiderato.