AI w muzyce

Możliwości muzyki napędzanej AI od lat mruczą pod powierzchnią branży muzycznej, ale dopiero w wydaniu Chatgpt w 2022 r. Rozpoczęła się szersza rozmowa wokół AI w głównym nurcie. Jesteśmy teraz w punkcie, w którym niektórzy muzycy i specjaliści z branży muzycznej są zafascynowani możliwościami muzyki napędzanej sztucznej inteligencji, podczas gdy inni są ostrożni wobec nieznanego, szczególnie gdy regulacja jest jeszcze w powijakach. Badanie przeprowadzone przez firmę dystrybucji muzyki Ditto wykazało, że prawie 60 procent ankietowanych artystów twierdzi, że korzysta z sztucznej inteligencji w swoich projektach muzycznych, a 28 procent twierdzi, że nie użyłby sztucznej inteligencji do celów muzycznych.

Christopher nosi, stowarzyszony przewodniczący działu biznesowego/zarządzania w Berklee College of Music, jest zwolennikiem technologii muzycznej AI. Napisał nawet tezę mistrza o tym, dlaczego Warner Music powinien inwestować w sztuczną inteligencję w 2016 roku (alert spoilera: tak, wraz z każdą inną ważną wytwórnią). Wares wprowadził sztuczną inteligencję na swoje kursy w Berklee i widział mieszane reakcje studentów.

„Niektórzy z moich uczniów uwielbiają sztuczną inteligencję i już go używają na różne sposoby, podczas gdy inni nie chcą z tym nic wspólnego” - mówi Wares. „W rozmowach jest wiele gorących debaty i staram się zachęcić moich uczniów do przyjęcia technologii i znalezienia nowych sposobów wykorzystania jej w celu poprawy ich procesów twórczych”.

Innym autorem i instruktorem kursu o podobnym sposobie myślenia jest Ben Camp, profesor nadzwyczajny w pisaniu piosenek w Berklee College of Music i autor Songs Unmasted: Techniques and Wskazówki dotyczące sukcesu pisania piosenek. Byli fascynowani technologią sztucznej sztucznej technologii od 2016 roku, po usłyszeniu „Daddy's Car”, jednej z pierwszych piosenek popu AI, w których AI została przeszkolona w muzyce Beatlesów.

Obóz daje również swoim uczniom możliwość nauki sztucznej inteligencji w klasie, o ile sprawdzają wszystkie informacje, których uczą się z Chatgpt lub dowolnego dużego modelu języka.

„Myślę, że każdy musi dokonać własnego wyboru”, mówi Camp. „Mam na myśli, że mam przyjaciół, którzy nadal używają telefonów Flip, ponieważ nie są komfortowe z posiadaniem wszystkich swoich informacji na telefonie. Mam przyjaciół, którzy nadal mają linie stacjonarne. Więc nie mówię: „Hej, wszyscy, musisz to zrobić”. Ale to zdecydowanie tu jest. To nie odchodzi. Będzie tylko lepiej ”.

Niezależnie od tego, czy aktywnie używasz sztucznej inteligencji w swojej muzyce, czy masz pewne wątpliwości, staje się coraz bardziej jasne, że AI będzie odgrywać ważną rolę w branży muzycznej w przyszłości. Dzięki wiedzy specjalistycznej towarów i obozu omawiamy obecny stan sztucznej inteligencji w branży muzycznej, w tym narzędzia, które są teraz dostępne.

Co to jest muzyka AI?

Zanim zdefiniujemy, co oznacza muzyka AI, najpierw zdefiniujmy sztuczną inteligencję. Oto definicja towarów:

„Sztuczna inteligencja jest jak inteligencja komputera; Jest to technologia, która umożliwia maszynom naśladowanie ludzkiego myślenia lub zachowania, takie jak rozwiązywanie problemów, uczenie się lub rozpoznawanie wzorców. ”

W kontekście muzyki technologia AI osiągnęła punkt, w którym może generować, komponować i ulepszać treści muzyczne, które wcześniej wykonywali ludzie. Muzyka AI może przybierać wiele form i rodzajów pomocy, od tworzenia całej piosenki od początku do końca, po pisanie określonych aspektów kompozycji, miksowanie i opanowanie produkcji, klonowania głosu i innych. Wymieścimy również kilka konkretnych narzędzi muzycznych AI, które mogą wykonywać te zadania, których możliwości otworzyły pudełko Pandory z problemami z prawami autorskimi.

Historia

Sztuczna inteligencja ma swoje pochodzenie w muzyce, z problemem transkrypcji: dokładnie zapisując występ w notacji muzycznej podczas jej wykonywania. Schemat „Tape fortepianowy” Père Engramelle, tryb automatycznego rejestrowania czasów i czasów trwania, aby można je było łatwo przepisać w właściwej notacji muzycznej ręcznie, został po raz pierwszy zaimplementowany przez niemieckich inżynierów JF Unger i J. Holfield w 1752 r.

W 1957 r. Iliac I (automatyczny komputer Illinois) stworzył „Ilaks Suite for String Quartet”, całkowicie generowany komputerowo utwór muzyczny. Komputer został zaprogramowany do wykonania tego zadania przez kompozytor LeJaren Hiller i matematyka Leonarda Isaacsona. : V-VII W 1960 r. Rosyjski badacz Rudolf Zaripov opublikował pierwszy światowy artykuł na temat kompozycji muzycznej algorytmicznej za pomocą komputera URAL-1.

W 1965 r. Wynalazca Ray Kurzweil opracował oprogramowanie, które mogło rozpoznać muzyczne wzorce i zsyntetyzować z nich nowe kompozycje. Komputer pojawił się po raz pierwszy w quizie, że mam sekret.

W 1983 r. System muzyczny Kansei Yamaha zyskał przyczepność, a artykuł na temat jego rozwoju został opublikowany w 1989 roku. Oprogramowanie wykorzystano techniki przetwarzania muzyki i sztucznej inteligencji, aby zasadniczo rozwiązać problem transkrypcji prostszych melodii, chociaż melodie wyższego poziomu i złożoności muzyczne są Wciąż uważane za trudne problemy z głębokim uczeniem się i prawie idealna transkrypcja jest nadal przedmiotem badań.

W 1997 r. Program sztucznej inteligencji o nazwie Experiments in Musical Intelligence (EMI) przewyższył ludzkiego kompozytora na zadanie skomponowania utworu muzyki naśladującej styl Bacha. Później EMI stała się podstawą bardziej wyrafinowanego algorytmu o nazwie Emily Howell, nazwaną na cześć jego twórcy.

W 2002 r. Grupa badaczy muzycznych z Sony Computer Science Laboratory w Paryżu, kierowana przez francuskiego kompozytora i informatyka François Pachet, rozwinęła Continuator, wyjątkowy algorytm zdolny do ponownego uruchomienia kompozycji po zatrzymaniu muzyka na żywo.

Emily Howell nadal ulepszała sztuczną inteligencję muzyki, wydając swój pierwszy album z Darkness, Light, w 2009 roku. Od tego czasu różne grupy opublikowało wiele innych prac AI.

W 2010 roku IAMUS stał się pierwszą sztuczną inteligencją, która stworzyła kawałek oryginalnej nowoczesnej muzyki klasycznej we własnym stylu: „IAMUS” Opus 1 ”. Komputer, położony na University of Malaga (University of Malaga) w Hiszpanii, może wygenerować całkowicie oryginalny utwór muzyczny w różnych stylach muzycznych. W sierpniu 2019 r. Utworzono duży zestaw danych 12 197 piosenek MIDI, z których każda z własnymi tekstami i melodiami, w celu zbadania wykonalności neuralnie generujących melodie z tekstów piosenek przy użyciu głębokiej warunkowej metody LSTM-GAN.

Dzięki postępom w generatywnej sztucznej inteligencji zaczęły pojawiać się modele, które mogą tworzyć kompletne kompozycje muzyczne (w tym teksty) z prostych opisów tekstu. Dwie znaczące aplikacje internetowe w tym obszarze to Suno AI, która została uruchomiona w grudniu 2023 r., I Udio, która nastąpiła w kwietniu 2024 r.

Applafice

Cmokanie

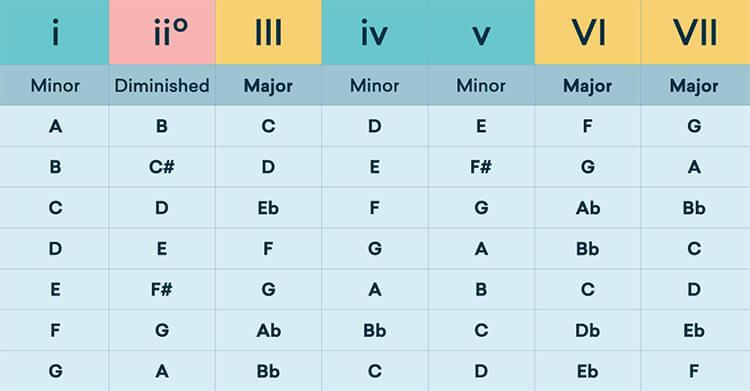

Opracowany na Uniwersytecie Princeton przez Ge Wang i Perry Cook, Chuck to język tekstowy, międzyplatformowy. Wyodrębniając i klasyfikując techniki teoretyczne, które znajduje w utworach muzycznych, oprogramowanie jest w stanie syntetyzować zupełnie nowe utwory w oparciu o techniki, których się nauczył. Technologia jest używana przez SloK (Stanford Laptop Orchestra) i Plork (Princeton Laptop Orchestra).

Szafa grająca

Jukedeck był stroną internetową, która pozwoliła ludziom korzystać z sztucznej inteligencji do tworzenia oryginalnej muzyki bez królestwa do użytku w filmach. Zespół rozpoczął opracowywanie technologii generującej muzykę w 2010 roku, utworzył wokół niej firmę w 2012 r. I publicznie uruchomił stronę internetową w 2015 r.. Zastosowana technologia była początkowo opartym na regułach systemu kompozycji algorytmicznej, który został później zastąpiony sztucznymi sieciami neuronowymi. Witryna została wykorzystana do generowania ponad 1 miliona utworów muzycznych, a marki, które go używały, obejmowały Coca-Cola, Google, UKTV i Muzeum Historii Naturalnej w Londynie. W 2019 r. Firma została przejęta przez Bytedance.

Morpheus

Morpheus to projekt badawczy Dorien Herremans i Elaine Chu z Queen Mary University of London, finansowany przez projekt UE Marie Skłodowska-Curie. System wykorzystuje podejście optymalizacyjne oparte na zmiennym algorytmie wyszukiwania sąsiedztwa w celu przekształcenia istniejących wzorzystej fragmenty w nowe fragmenty z danym poziomem naprężenia tonalnego, który zmienia się dynamicznie przez cały fragment. To podejście optymalizacji integruje techniki wykrywania wzorców w celu zapewnienia długoterminowej struktury i powtarzających się tematów w generowanej muzyce. Układy złożone przez Morfeusza zostały wykonane na koncertach zarówno w Stanford, jak i w Londynie.

Aiva

Aiva, założona w lutym 2016 roku w Luksemburgu, to program, który produkuje ścieżki dźwiękowe dla każdego rodzaju mediów. Algorytmy stojące za AIVA oparte są na architekturach głębokiego uczenia się. Aiva była również używana do komponowania rockowego utworu o nazwie The Edge, a także popowej melodii o nazwie Love Sick, we współpracy z piosenkarką Taryn Southern za jej album I Am AI.

Google Purple

Zespół Magenta Google opublikował kilka aplikacji muzycznych AI i białych artykułów od czasu ich uruchomienia w 2016 roku. W 2017 r. Wydali algorytm i zestaw danych NSYNTH, instrument muzyczny open source zaprojektowany tak, aby ułatwić muzykom korzystanie z algorytmu. Instrument był używany przez znanych artystów, takich jak Grimes i Yacht na ich albumach. W 2018 r. Wydali aplikację improwizacji fortepianowej o nazwie Piano Genie. Później nastąpiło Magenta Studio, zestaw 5 wtyczek MIDI, które pozwalają producentom muzycznym rozwijać istniejącą muzykę w ich DAW. W 2023 r. Ich zespół uczenia maszynowego opublikował artykuł techniczny na temat GitHub opisujący MusicLM, opracowany przez nich generator tekstu do muzyki.

Riffia

Riffusion to sieć neuronowa opracowana przez Setha Forsgrena i Ike Martiros, która generuje muzykę za pomocą wzorów dźwięku, a nie dźwięku. Został stworzony jako dopracowanie stabilnej dyfuzji, istniejący model open source do generowania obrazów z wskazówek tekstowych w spektrogramach. Powoduje to model, który wykorzystuje sygnały tekstowe do generowania plików obrazów, które mogą być odwrotne przekształcone i przekonwertowane na pliki audio. Chociaż pliki te mają zaledwie kilka sekund, model może również wykorzystać utajoną przestrzeń między wyjściami, aby połączyć różne pliki razem. Osiąga się to za pomocą funkcjonalności stabilnego modelu dyfuzyjnego znanego jako IMG2IMG. Powstała muzyka została opisana jako „De Otro Mundo” (nieziemski), choć jest mało prawdopodobne, aby zastąpić muzykę wykonaną przez ludzi. Model został wydany 15 grudnia 2022 r., A kod jest również swobodnie dostępny w GitHub. Jest to jeden z wielu modeli pochodzących ze stabilnej dyfuzji. Riffuzja jest klasyfikowana jako podzbiór generatorów tekstu do muzyki opartych na sztucznej inteligencji. W grudniu 2022 r. Mubert podobnie zastosował stabilną dyfuzję, aby przekształcić tekst opisowy w pętle muzyczne. W styczniu 2023 r. Google opublikował artykuł na własny generator tekstu do muzyki o nazwie MusicLM.

Spike AI

Spike AI to wtyczka audio opracowana przez Spike Stent we współpracy z jego synem Joshua Stent i przyjacielem Henry'm Ramseyem, który analizuje utwory i rekomendacje dotyczące jasności i innych aspektów podczas miksowania. Komunikacja odbywa się za pośrednictwem chatbota przeszkolonego na podstawie danych osobowych Spike Stent. Wtyczka integruje się z cyfrową stacją roboczą audio.

Aplikacje muzyczne

Sztuczna inteligencja może wpływać na sposób, w jaki producenci tworzą muzykę poprzez generowanie iteracji utworów na podstawie wskazówek podanych przez Stwórcę. Te wskazówki pozwalają sztucznej inteligencji podążać za określonym stylem, który artysta próbuje osiągnąć.

AI została również wykorzystana w analizie muzyki, w której została wykorzystana do ekstrakcji funkcji, rozpoznawania wzorów i zaleceń muzycznych.

Kompozycja

Sztuczna inteligencja miała duży wpływ na sektor kompozycji, ponieważ wpłynęła na idee kompozytorów/producentów i może uczynić branżę bardziej dostępną dla nowo przybyłych. Wraz z rozwojem muzycznym był już wykorzystywany we współpracy z producentami. Artyści używają tego oprogramowania do generowania pomysłów i identyfikacji stylów muzycznych, zachęcając sztuczną inteligencję do przestrzegania określonych wymagań, które odpowiadają ich potrzebom. Przyszłe skutki technologii na skład obejmują emulację i fuzję stylów, a także rewizję i udoskonalenie. Opracowanie tego rodzaju oprogramowania może ułatwić nowicjuszom wejście do branży muzycznej. Oprogramowanie, takie jak Chatgpt, było używane przez producentów do wykonywania tych zadań, podczas gdy inne oprogramowanie, takie jak Ozone11, było używane do automatyzacji czasochłonnych i złożonych zadań, takich jak mastering.

Ryzyko i szkody

Muzycy, producenci i inni od lat korzystają z nie generacyjnych narzędzi AI. Cher spopularyzował auto-melodię z „uwierzeniem” ponad ćwierć wieku temu, a od tego czasu niezliczeni artyści użyli go do „poprawienia” swojego tonu. Etykiety płytowe używają sztucznej inteligencji do skanowania mediów społecznościowych w celu uzyskania nielicencjonowanych zastosowań, które posiadają, a Shazam działa w ten sam sposób, jeśli chodzi o rozpoznawanie dźwięku. Inżynierowie używają go do usprawnienia procesu miksowania i masteringu. Niedawno reżyser Get Back Peter Jackson wykorzystał tę technologię do izolowania poszczególnych utworów od mieszanego nagrania w celu odtworzenia rozmów studyjnych i stworzenia utraconej piosenki Beatlesów.

Istnieje jednak kluczowa różnica między tymi dodatkowymi narzędziami a generatywnymi aplikacjami AI, takimi jak Suno i Udio, które mogą tworzyć całe piosenki z zaledwie kilku słów. Wszystkie nowe AI muzyczne działają nieco inaczej i nadal ewoluują, ale ogólnie działają w podobny sposób jak inne generatywne narzędzia AI: analizują ogromny zestaw danych i wykorzystują wzorce znalezione w nim, aby dokonać prognoz probabilistycznych.

Aby to zrobić dla audio, programiści zbierają ogromną kolekcję piosenek (poprzez umowy z posiadaczami licencji i/lub poprzez skrobanie publicznie dostępnych danych bez pozwolenia) i powiązanych metadanych (artystów i utworów, gatunki, lata, opisy, adnotacje, wszystko istotne i dostępne). Wszystko to jest zwykle możliwe przez nisko opłacanych pracowników na globalnym Południu, którzy opowiadają te dane na gigantyczną skalę.

Następnie programiści przygotowują ten zestaw danych do modelu uczenia maszynowego, który jest (w skrócie) rozległej sieci połączeń, z których każda przypisała liczbową „wagę”. Ludzie następnie „szkolą” model, ucząc go, aby obserwować wzorce w zestawie danych i przekazując modelu informacje zwrotne poprzez ocenę jego prognoz. W oparciu o te wzorce model może wziąć krótki kawałek wskazówki audio lub tekstu i przewidzieć, co powinno być dalej, a potem, co stanie się po tym i tak dalej.

Deweloperzy poprawiają wagi, aby wygenerować bardziej słuchowe i przewidywalne wyniki z tych samych danych wejściowych. Generatory muzyczne napędzane AI łączą dwa pasma technologii: muzyczne narzędzia, z których profesjonaliści używają w studiach od dziesięcioleci, a także duże modele językowe, które pozwalają codziennym użytkownikom wykorzystać swoją moc. Każdy generator muzyki AI jest tak dobry, jak dane, na których jest przeszkolony. Systemy te wymagają ogromnych ilości danych, a model wyszkolony na stronniczym zestawie danych będzie odtworzyć te uprzedzenia w jego wydajności. Czyje głosy są zawarte w tym ogromnym pudełku muzycznym i czyj zostaną pominięte? Dzisiejsze modele AI wykluczają ogromne pokosy muzyczne, szczególnie z tradycji muzycznych, które poprzedzają technologię nagrywania i mają pochodzenie niezachodnie. Jak obecnie zaprojektowano, częściej wytwarzają stereotypowe dźwięki w gatunku lub stylu niż coś niezwykłego, nie mówiąc już o innowacyjnym lub interesującym. Generatywne systemy AI są podatne na przeciętność, ale muzyka transcendentalna znajduje się na obrzeżach.

„Co zostanie utracone w ludzkiej kreatywności i różnorodności, jeśli muzycy zaczną polegać na modelach predykcyjnych przeszkolonych na selektywnych zestawach danych, które wykluczają większość kultur i języków świata?” Lauren Me Goodlad, przewodnicząca krytycznej inicjatywy AI Uniwersytetu Rutgers, powiedziała mi.

Z prawnego punktu widzenia muzycy obserwujący modele AI uczące się z pracy mają takie same obawy, jak New York Times, Getty oraz inni wydawcy i twórcy, którzy pozywają firmy AI: pochodzenie danych. Podczas gdy niektóre firmy starają się szkolić swoje modele tylko na licencjonowanych danych, inne używają wszystkiego, co mogą zdobyć, argumentując, że wszystko w domenie publicznej jest w tym celu dozwolone. Riaa, dominujące ciało handlu muzycznego w USA, pozywa teraz Suno i Udio za „naruszenie praw autorskich… na ogromną skalę”. (Ujawnienie: Vox Media jest jednym z kilku wydawców, którzy podpisali umowy partnerskie z Openai. Nasze raportowanie pozostaje niezależne od redakcji).

Ankiety często pokazują, że większość ludzi nie pochwala firm AI kopiujących dane publiczne bez pozwolenia. Ale chociaż na stole istnieje wiele głośnych procesów sądowych, nie jest jeszcze jasne, w jaki sposób system prawny wpłynie na firmy wydobywający całą tą ludzką kreatywność bez pozwolenia, nie mówiąc już o ich zrekompensowaniu. Jeśli te praktyki nie zostaną wkrótce ograniczone, najmniej skrupulatni gracze szybko zyskają władzę oraz fantazyjnych lobbystów i prawników. (Bezdała: nie dotyczy tylko maszyn!) Te problemy są teraz naciskające, ponieważ z czasem trudniej się rozwiązać, a niektóre w terenie odpychają. Ed Newton-Rex był wiceprezesem ds. Audio w AI Stability, kiedy uruchomił Stable Audio, generator muzyki i dźwięku napędzany AI, zeszłej jesieni.

Kilka miesięcy później opuścił firmę w sprawie zbierania danych: zespół Newton-Rex przeszkolił stabilny dźwięk tylko w zakresie licencjonowanych danych, ale kierownictwo firmy złożyło publiczny komentarz w amerykańskim biurze autorskim, że rozwój AI był „akceptowalnym , transformacyjne i społecznie korzystne wykorzystanie istniejących treści chronionych przez dozwolone użycie. ” Aby zwalczyć nielicencjonowane skrobanie, Newton-Rex założył dość przeszkolony, który weryfikuje i certyfikuje zestawy danych wykorzystywane przez firmy AI. Na razie organizacja non -profit może tylko poświadczyć, czy treść w zestawie danych firmy została odpowiednio licencjonowana. Pewnego dnia będzie mógł wziąć pod uwagę drobniejsze szczegóły (np. To, czy artysta wyraźnie wyraził zgodę na takie użycie lub po prostu nie zrezygnował) i inne problemy, takie jak ograniczenie uprzedzeń.

Jako muzyk i kompozytor muzyki chóralnej i fortepianowej uważa to za punkt zwrotny dla pola. „Generatywne modele AI zwykle konkurują z danymi szkoleniowymi”, powiedział Newton-Rex. „Szczerze mówiąc, ludzie mają ograniczony czas na słuchanie muzyki. Istnieje ograniczona pula opłat licencyjnych. Im więcej muzyki, która jest tworzona przez te systemy, tym mniej dotyczy ludzkich muzyków. ”

Jak zauważyła przewodnicząca FTC Lina Khan w zeszłym miesiącu, jeśli dana osoba tworzy treść lub informacje, które kopiuje firma AI, a następnie treść lub informacje opracowane przez generator AI konkuruje z oryginalnym producentem „w celu wypędzenia go z rynku i rozdzielczości Biznes… może to być niesprawiedliwą metodą konkurencji ”, która narusza przepisy antymonopolowe.

Marc Ribot jest jednym z ponad 200 muzyków, którzy podpisali oświadczenie Artist Rights Alliance sprzeciwiające się praktyce na początku tego roku, i jest aktywnym członkiem komitetu sterującego AI Sojuszu Muzycznego Sojuszu Sojuszu. Praktykujący gitarzysta od lat 70. Ribot widział, jak technologia kształtowała branżę, obserwując, jak budżety nagraniowe stale zmniejszają się od dziesięcioleci.

„W żadnym wypadku nie jestem przeciwny samej technologii, kształtowi ani formie” - mówi Ribot. Po stracie głównych nagrań, które dokonał w latach 90., on sam użył sztucznej inteligencji do izolowania poszczególnych utworów od ostatniego miksu. Ale uważa obecny moment jako krytyczną okazję do odepchnięcia technologii przed własnymi firmami, które staną się zbyt duże, aby go regulować.

„Prawdziwa linia podziału między przydatną i katastrofalną jest bardzo prosta” - powiedział Ribot. „Chodzi o to, czy producenci muzyki czy cokolwiek innego jest wprowadzane [ponieważ dane szkoleniowe] mają prawdziwe, funkcjonalne prawo zgody. [Generatory muzyki AI] wypluć to, co spożywają, i często produkują rzeczy z dużymi kawałkami materiałów chronionych prawem autorskim. To jest wyjście. Ale nawet jeśli nie, nawet jeśli dane wyjściowe nie naruszają, samo dane wejściowe narusza. ”

Ribot powiedział, że muzycy od dawna są obojętni na sztuczną inteligencję, ale w ciągu ostatnich kilku lat widział „sejsmiczną zmianę postaw wobec kwestii cyfrowej eksploatacji”, napędzana zeszłorocznymi strajkami SAG-Aftra i pisarzy, które są trwające procesy sądowe przeciwko firmom AI oraz lepsze zrozumienie kapitalizmu i wolności obywatelskich.

Podczas gdy muzycy mogli postrzegać się jako konkurentów zaledwie kilka lat temu - nawet jeśli ciasto staje się coraz mniejsze, wciąż jest kilku artystów, którzy mogą się wzbogacić - stwarza zagrożenie dla całej branży, która może nie przynieść korzyści nawet najszczęśliwszych z ich.

Co może i może zrobić

Jeden z pierwszych przykładów muzyki stworzonej przez sztuczną inteligencję pochodzi z 1956 roku: utwór do kwartetu smyczkowego skomponowanego przez komputer Iliac I i zaprogramowany przez University of Illinois w Urbana-Champaign Profesors LeJaren Hiller i Leonard Isaacson.

Po technologicznych skokach z ostatnich lat artyści tacy jak Holly Herndon, ARCA, Yacht, Taryn Southern i Brian Eno używają teraz generatywnej sztucznej inteligencji do eksperymentowania z ich twórczymi praktykami. Tendencja AI do tworzenia „halucynacji” i innych nonsensownych rezultatów, choć niebezpieczna w innych kontekstach, może być źródłem inspiracji w muzyce. Podobnie jak inne technologie audio zostały zdefiniowane przez ich dysonans-zniekształcenie, 8-bitowe kompresję, pęknięty ludzki głos zbyt potężny dla gardła, który go emituje, „zdarzenia zbyt ważne, aby medium przeznaczone” jako Brian Eno pisze w ciągu roku z spuchniętymi dodatkami-muzyka generowana przez AAR może być najcenniejsza, gdy jest najbardziej wyraźna. Ivan Paz, muzyk z doktoratem z informatyki, opracowuje systemy AI na własne występy na żywo.

Począwszy od pustego ekranu, pisze kod w czasie rzeczywistym (wyświetlany publiczność do czytania) i trenuje model, odpowiadając na dźwięki, które mogą być nieoczekiwane, wstrząsające lub po prostu katastrofalne. Rezultat jest trochę jak odtwarzanie instrumentu, ale także improwizowanie z innym muzykiem. „Jeśli twój algorytm działa na bardzo niskim poziomie, czujesz, że grasz w instrument muzyczny, ponieważ faktycznie poprawiasz, na przykład parametry syntezy” - powiedział Paz. „Ale jeśli algorytm określa kształt utworu muzycznego, to tak, jakby grać z agentem, który decyduje o tym, co będzie dalej”.

Na wystawę w Center for Contemporary Culture w Barcelonie na początku tego roku Paz współpracował z piosenkarką Marią Arnal, aby stworzyć modelkę dla jej głosu. Poprosili gości o śpiewanie krótkich fragmentów piosenek; Model następnie wymieszał te głosy z Arnalem, aby stworzyć nowy głos śpiewający. W innym projekcie, koleżanka Paza, Shelley Knotts, wyszkoliła modelkę we własnych kompozycjach, aby uniknąć powtórzeń w swojej pracy: analizuje jej muzykę do wykrywania wzorców, ale zamiast sugerować jej najprawdopodobniej następny ruch, sugeruje mniej prawdopodobną kontynuację.

Kolejny krok w muzycznej ewolucji AI może sprowadzać się do prędkości przetwarzania. Kodowanie na żywo jest możliwe w przypadku niektórych rodzajów modeli, ale inni zajmują zbyt długo, aby renderować muzykę, aby stworzyć ją w programie na żywo. Instrumenty elektroniczne, takie jak syntezatory, zostały pierwotnie zaprojektowane w celu naśladowania dźwięków akustycznych i z czasem opracowały swój unikalny charakter. Paz postrzega ostateczny potencjał generatywnej sztucznej inteligencji jako tworzenie nowych dźwięków, których obecnie nie możemy sobie wyobrazić, nie mówiąc już o produkcji. W tym kontekście - w którym AI pomaga wykonawcy - AI nie jest bardziej prawdopodobne, że „zastąpi” muzyka niż cyfrowy tuner lub pedał opóźnienia.

Jednak inne zakątki branży muzycznej przyjmują sztuczną inteligencję w celu bardziej destrukcyjnych celów. Chociaż AI nie może (i nigdy nie może) tworzyć muzykę lepiej niż człowiek, może teraz tworzyć akceptowalną muzykę z znacznie szybszą prędkością i na większą skalę - a „akceptowalne” jest często jedynym paskiem, który utwór musi usunąć.

Przez większość czasu, kiedy słyszysz muzykę, nie wiesz, kto ją stworzył. Jingle, które słyszysz w reklamie. Wynik otoczenia w filmie lub programie telewizyjnym, podcastie lub gry wideo. Pętle producenta hip-hopu próbki w rytm. Jest to część branży, która najprawdopodobniej zostanie uruchomiona przez generatywną sztuczną inteligencję. Bloomberg donosi, że nauczyciele używają Suno do tworzenia pomocy dydaktycznych muzycznych. Gizmodo zauważa, że docelowi odbiorcy Adobe's Project Music Genai Control, inny generator muzyki napędzany sztuczną inteligencją, to ludzie, którzy chcą szybko i tanio tworzyć muzykę w tle, jak podcasters i youtubers, z możliwością określenia nastroju, tonu i długości. utwór.

Niezależnie od tego, czy ci się to podoba, czy nawet zauważysz, tego rodzaju muzyka zostały historycznie stworzone przez ludzi. Ale zautomatyzowane generowanie muzyki sztucznej inteligencji może kosztować tych muzyków ich pracy - i wielu z nich wykorzystuje ten dochód do wspierania ich bardziej twórczo satysfakcjonujących, ale mniej opłacalnych finansowo, zajęć. Możesz nigdy nie zobaczyć muzyka AI na scenie, ale prawdopodobnie nadal zobaczysz mniej ludzkich muzyków z powodu technologii.

Ze swojej strony wpływowych graczy w branży muzycznej już uważają, że AI stanie się ostoją ich działalności - martwią się, kto będzie czerpał korzyści. Spotify nie ogranicza muzyki generowanej przez AI, chyba że jest to bezpośrednia imitacja, która ryzykuje spory sądowe. Universal Music Group (UMG) i YouTube uruchomiły inkubator AI YouTube Muzyka w celu opracowania narzędzi AI z artystami UMG. Tymczasem UMG jest również jedną z ponad 150 organizacji-w tym ASCAP, BMI, RIAA i AFL-CIO-w Koalicji Kampanii Krajowej, która ma na celu ustanowienie ram etycznych do korzystania z AI w dziedzinach kreatywnych. Nie chcą zakazać technologii, ale chcą udziału w wynikach.

Dzięki ponad 100 000 nowych utworów przesyłanych codziennie do usług przesyłania strumieniowego, cyfrowe platformy strumieniowe mają silną motywację do ograniczenia udziału w opracowanych przez człowieka, bezbłędnych śledzonych przez użytkowników. Sam Spotify wypłacił w ubiegłym roku 9 miliardów dolarów tantiem, masę przychodów 14 miliardów dolarów. Największa na świecie firma strumieniowa muzyki historycznie zwiększyła dostępność i widoczność bezpłatnych utworów i może to nadal robić. Generatory muzyczne napędzane AI to łatwy sposób na tworzenie bezpłatnej muzyki, która mogłaby wypierać prawdziwych artystów zarabiających na popularnych listach odtwarzania, zmieniając ten strumieniowe dochody z artystów i do samej platformy.

Jest nowa moc - i nowe niebezpieczeństwo - dla uznanych artystów. Po udarze Randy Travis, gwiazda country, ma problem z mówieniem, nie mówiąc już o śpiewaniu, ale z pomocą AI wyszkolonych w swoim istniejącym katalogu może odtworzyć swój wokal cyfrowo.

Tymczasem anonimowy producent może stworzyć wiarygodnie brzmiącym Drake/The Weeknd Collaboration i zebrać miliony strumieni. W maju producent Metro Boomin znalazł się pod ostrzałem podczas prawdziwej wołowiny Drake'a z Kendrickiem Lamarem. Metro Boomin wydał rytm z próbkami generowanymi przez AI dla każdego, kto mógłby użyć, którego Drake pobrał i rapował, uwalniając nowy utwór do usług streamingowych. Król Willonius, który użył Udio do stworzenia oryginalnego utworu, który Metro Boomin zremiksował, zatrudnił prawnika, aby zachował prawa do jego wkładu.

Te najnowsze przykłady pokazują, jak szybko wytwarzana muzyka może dobrze wytwarzać muzykę. W gospodarce strumieniowej wolumen i prędkość są wszystkim: artyści zachęca się do wytwarzania ilości, a nie jakości.

„[Przyszły hit generowany przez AI] nie będzie czymś, co ludzie wracają i studiują sposób, w jaki nadal robią z wielkimi wydawnictwem epoki płyty”-powiedział muzyk Jamie Brooks. Brooks opublikowała płyty pod własną nazwą oraz z Elite Gymnastics i domyślnymi płciami zespołów oraz blogami o branży muzycznej w swoim biuletynie Seat of Loss. „Ale nadal generuje zaangażowanie, a więc świat, w którym wszystko, co jest na szczycie list przebojów Spotify, nie ma trwać, to po prostu zabawne tego dnia i nigdy więcej nie myślały, byłoby dobrą rzeczą dla wszystkich tych firm . Nie potrzebują sztuki, aby zarabiać pieniądze.

„Tak wiele dzisiejszych technologii istnieje przede wszystkim naśladowanie lub uproszczenie, co może sprzyjać amatorium. Udostępnianie plików sprawiło, że kompulsywne zbieranie rekordów dostępnych dla każdego z dysku twardym i modemem, aparaty komórkowe, pozwoliły wszystkim w tłumie udokumentować program, a teraz przesyłanie strumieniowe dźwięku daje nam wszystkie dynamiczne listy odtwarzania dostosowane do naszych nastrojów i reklamowych kohort. Generatywna sztuczna inteligencja może ułatwić tworzenie muzyki również dla osób nie-ekspertów. Może to radykalnie zmienić nie tylko, ile muzyki słyszymy, ale nasz związek z formą jako całości. Jeśli utworzenie przebojowej piosenki nie wymaga więcej wysiłku niż napisanie wirusowego tweeta, większość kreatywnej energii zawartej obecnie w mediach społecznościowych może zostać przekierowana w kierunku generowania muzyki na podstawie podpowiedzi.

Brooks postrzega to jako zjawisko regresywne, podkreślając natychmiastową ponadczasową głębię, na szczycie list memów audio i przełomowych singli skierowanych do najbardziej wyrafinowanych słuchaczy, podobnie jak fale radiowe były kiedyś zdominowane przez puste piosenki, takie jak „Take Me Out To the Ball Game ”Napisane przez dwie osoby, które nigdy nie były w meczu baseballowym.

„W tym kierunku te usługi popchną muzykę” - powiedział Brooks. „W ogóle nie chodzi o kreatywność. Pomiędzy sposobem działania tych modeli a kanałami algorytmicznymi jest to tylko duże repozytorium przeszłości. To nie będzie poruszać płyty naprzód w dźwięku. Będzie przyspieszyć rekordy od centrum amerykańskiej popkultury po kosz na śmieci. ”

Prawa autorskie i muzyka AI

Jeden z najbardziej debatowanych problemów związanych z sztucznej inteligencji w branży muzycznej, która zarabia pieniądze na pracy generowanej przez AI, zwłaszcza jeśli algorytm jest przeszkolony przy użyciu istniejących materiałów chronionych prawem autorskim. W marcu 2023 r. Urząd Copyright w USA rozpoczęło inicjatywę w celu zbadania problemów związanych z prawami autorskimi związanymi z AI. Obóz jest przekonany, że organy regulacyjne wkroczą i stworzą łatkę, ale martwi się, że problem jest trudny do rozwiązania z powodu amerykańskiego systemu praw autorskich, w którym działają artyści.

„Wiele przepisów i precedensów, które ostatecznie doprowadziły do naszego nowoczesnego systemu praw autorskich, po prostu nie pasuje do tego, co dzieje się teraz w muzyce”, mówi Camp. „Uważam, że twórcy powinni mieć autorstwo, powinni zostać przypisane i powinni zostać zrekompensowane. Ale znowu cały system, przez który to robimy, jest bardzo przestarzały. ”

Muzyka AI jest nadal w legalnej szarości, podnosząc pytanie, czy kompromis jest możliwy, gdy artyści są przypisani, rekompensowani, i wyrażają zgodę na wykorzystanie ich pracy lub podobieństwa przez sztuczną inteligencję, bez ograniczania potencjału kreatywności muzycznej za pomocą technologii AI. W pewnym stopniu sztuka jest pochodną innej sztuki, a inspiracją i tym, co kradzież jest obecnie niewyraźna. Niektóre etykiety rekordowe zaczynają walczyć.

W maju 2023 r. Universal Music Group wezwała usługi przesyłania strumieniowego, aby zablokować korzystanie z muzyki generowanej przez AI, mówiąc, że wykorzystuje muzykę ich artystów do szkolenia algorytmu i że w razie potrzeby podejmie działania prawne. Spotify odpowiedział, usuwając 7 procent muzyki generowanej przez AI na swojej platformie, co oznacza dziesiątki tysięcy piosenek. W lipcu 2023 r. UMG wezwał Kongres do uchwalenia ogólnokrajowej polityki w celu ochrony twórców przed naruszeniem praw autorskich napędzanych AI. Etykieta płytowa jest jednym z 40 członków, którzy dołączyli do kampanii kunsztu ludzkiej, organizacji opowiadającej się za odpowiedzialnym wykorzystaniem sztucznej inteligencji.

W Stanach Zjednoczonych obecne ramy prawne mają tendencję do stosowania tradycyjnych praw autorskich do AI, pomimo różnic w stosunku do ludzkiego procesu twórczego. Jednak prace muzyczne tworzone wyłącznie przez AI nie są chronione prawem autorskim. W kompendium praktyki w biurze autorskim Biuro Copyright oświadczyło, że nie przyznaje praw autorskich do „prac, które nie mają ludzkiego autorstwa”, a „Biuro nie zarejestruje utworów utworzonych przez maszynę lub przez sam proces mechaniczny, który działa losowo lub automatycznie bez automatycznie Wszelkie twórcze wkład lub interwencja ludzkiego autora. ” W lutym 2022 r. Rada Review Copyright odrzuciła wniosek o prawa autorskie o dzieło sztuki generowane przez AI, ponieważ „brakowało jej wymaganego autorstwa ludzkiego niezbędnego do utrzymania roszczenia o prawa autorskie”.

Sytuacja w Unii Europejskiej (UE) jest podobna do tej w Stanach Zjednoczonych, ponieważ jej ramy prawne podkreślają również rolę zaangażowania człowieka w dziełach chronionych prawem autorskim. Według Urzędu własności intelektualnej Unii Europejskiej i niedawnym orzecznictwem Sądu Sprawiedliwości Unii Europejskiej kryterium oryginalności wymaga, aby praca była własnym stworzeniem intelektualnym autora, odzwierciedlającą tożsamość autora, dowodzona twórczymi wyborami podczas jej tworzenia , wymagający określonego poziomu zaangażowania człowieka. Odtwarzający projekt Europy, finansowany z programu badań i innowacji w Horizon 2020 Unii Europejskiej, zagłębia się w wyzwania związane z treściami generowanymi przez AI, w tym muzyką, oferującą pewność prawną i zrównoważoną ochroną, która zachęca do innowacji, jednocześnie szanując zasady praw autorskich. Uznanie Aivy oznacza znaczące odejście od tradycyjnych poglądów na temat autorstwa i praw autorskich w dziedzinie kompozycji muzycznej, umożliwiając wykonawcom AI wydawanie muzyki i otrzymywanie opłat licencyjnych. To uznanie sprawia, że Aiva jest pionierem w formalnym uznaniu sztucznej inteligencji w produkcji muzycznej.

Ostatnie postępy w sztucznej inteligencji według grup takich jak stabilność sztucznej inteligencji, Openai i Google doprowadziły do ogromnej liczby procesów dotyczących naruszenia praw autorskich w stosunku do technologii generatywnych, w tym AI Music. Jeśli te pozwy są powodzenia, zestawy danych modeli uczenia maszynowego, które zasilają te technologie będą ograniczone do domeny publicznej.

Drake i The Weeknd

Chociaż nie ma dużego precedensu do klonowania głosu, dla celebrytów może podlegać ich prawowi reklamy jako naruszenia ich wizerunku, imienia i głosu. Jednym z kluczowych przykładów z ubiegłego roku było to, że tiktoker, który ma na imię Ghostwriter używał sztucznej inteligencji, aby stworzyć fałszywy duet między Drake a The Weeknd zatytułowany „Heart on My Sleeve”. Od tego czasu piosenka została usunięta, ale wersje wciąż unoszą się w Internecie.

„Z jednej strony można argumentować, że jest to oryginalna praca”, mówi Wears. „Z drugiej strony można to postrzegać jako formę naruszenia, ponieważ AI nauczyła się pisać teksty w stylu Drake'a, analizując jego katalog, bez jego wyraźnej zgody. Innym problemem jest nieautoryzowane użycie nazwisk i podobieństw artystów. ”

Możliwość kopiowania czyjejś nazwy i podobieństwa za pomocą sztucznej inteligencji niepokoi branżę muzyczną, a także branżę rozrywkową jako całość. Jednym z głównych wymagań obecnego strajku SAG-AFTRA jest ochrona twórców przed wykorzystywaniem ich pracy do szkolenia generatorów AI oraz aktorów przed kopiowaniem ich podobieństw i głosów bez zgody.

Problemy etyczne z AI

Prawa autorskie to tylko jeden z wielu problemów etycznych wokół sztucznej inteligencji i ważne jest, aby pamiętać, że ta technologia i jej rozwój nie są pozbawione konsekwencji.

Jednym z bezpośrednich problemów jest odchylenie w szkoleniu zestawu danych. Przykładem jest raper FN Meka, który podpisał kontrakt z Capitol Music Group w 2022 r., Ale później porzucił umowę z powodu utrwalania stereotypów rasowych.

„Jednym z największych problemów są śmieci i śmieci”, mówi Camp. „Jeśli trenujemy te modele językowe, generatory obrazów lub te generatory muzyki na temat danych, które są z natury stronnicze, z natury rasistowskie, wszystko, co prosimy, będzie utrwalone te stereotypy. Musimy upewnić się, że mamy dobre dane i że je monitorujemy. ”

Monitorowanie tych danych również nie jest pozbawione szkód. Kolejnym problemem etycznym jest proces szkolenia, zwany „uczeniem się wzmocnienia”, który obejmuje przekazanie ludzkich informacji zwrotnych na temat szeregu niepokojących treści. Niedawny odcinek podcastu Wall Street Journal w czasopiśmie zawiera kenijski pracownik danych, który między innymi pomógł szkolił Chatgpt w odróżnieniu „dobra od zła” kosztem bardzo wysokiego zdrowia psychicznego.

„Zasadniczo daje kciuki w górę lub kciuki w dół odpowiedzi”, mówi Camp. „Czy to niewłaściwa odpowiedź? Czy jest to zbyt gwałtowne, graficzne czy niepokojące? Openai zawarł tę pracę z ludźmi w Kenii, płacąc im 2 USD za godzinę za przeczytanie tych odpowiedzi. Wyobraź sobie więc, że zapłacono 2 USD za godzinę, aby pojawić się za pracę i przeczytać jedne z najbardziej przerażających, niepokojących psychicznie tekstu, a ty robisz to przez 10 godzin, a potem wracasz do domu i wszystko wiruje w twojej głowie. Istnieje więc wiele wad, w jaki sposób powstaje kiełbasa. ”

Muzyka głębokie

Bardziej powstającym rozwojem sztucznej inteligencji w muzyce jest użycie audio głębokich szaf do sfałszowania tekstów lub muzycznego stylu istniejącej piosenki, aby przypominać głos lub styl innego artysty. Podniosło to wiele obaw dotyczących legalności technologii, a także etyki jej użycia, szczególnie w kontekście tożsamości artystycznej. Ponadto podniósł także pytanie, kto jest uznawany za te prace. Ponieważ sztuczna inteligencja nie może mieć własnego autorstwa, obecne spekulacje sugerują, że nie będzie żadnej jasnej odpowiedzi, dopóki nie będą podejmowane dalsze decyzje dotyczące technologii uczenia maszynowego w ogóle. Najnowsze środki zapobiegawcze zaczęły być opracowywane przez Google i Universal Music Group, które wzięły pod uwagę tantiemy i przypisanie kredytowe, aby umożliwić producentom kopiowanie głosów i stylów artystów.

„Serce na moim rękawie”

W 2023 r. Artysta znany jako Ghostwriter977 stworzył muzyczny głębokie fake o nazwie „Heart On My Sleeve”, który sklonował głosy Drake'a i Weeknd, przekazując zestaw wokalnych utworów od odpowiednich artystów w głębokie algorytm uczenia się, tworząc sztuczny model Głosy każdego artysty, które można by dopasować do oryginalnego wokalu referencyjnego z oryginalnymi tekstami. Utwór został przedłożony do rozważania Grammy za najlepszą piosenkę rap i piosenkę roku. Stał się wirusowy i zyskał popularność w Tiktoku i otrzymał pozytywną odpowiedź od publiczności, prowadząc do oficjalnego wydania Apple Music, Spotify i YouTube w kwietniu 2023 r. Wielu uważało, że utwór został całkowicie napisany przez oprogramowanie AI, ale producent twierdził, że to twierdził, że to twierdził, że to twierdził Pisanie piosenek, produkcja i oryginalny wokal (przed konwersją) były przez niego wykonywane. Piosenka została później usunięta z listy nominacji Grammy, ponieważ nie spełniała wymagań dotyczących rozważenia Grammy. Utwór został usunięty ze wszystkich platform muzycznych przez Universal Music Group. Piosenka była punktem zwrotnym klonowania głosu za pomocą sztucznej inteligencji i od tego czasu modele zostały stworzone dla setek, jeśli nie tysięcy, popularnych śpiewaków i raperów.

„Skąd to się pochodzi”

W 2013 roku piosenkarka country Randy Travis doznał udaru, który nie mógł go śpiewać. Tymczasem wokalista James Dupré koncertował w jego imieniu, wykonując swoje piosenki. Travis i długoletni producent Kyle Lehning wydali nową piosenkę w maju 2024 r. Zatytułowaną „Where That Wszeds”, pierwszą nową piosenkę Travisa od jego udarza. Nagrywanie wykorzystuje technologię sztucznej inteligencji do odtworzenia głosu wokalnego Travisa, opracowanego z ponad 40 istniejących nagrań wokalnych wraz z nagraniami Dupré.

Narzędzia muzyczne AI

Teraz, gdy omówiliśmy, czym jest AI, a także niektóre z jej głównych wad, możemy omówić istniejące narzędzia muzyczne AI. W Berklee Onsite 2023, corocznej konferencji muzycznej na kampusie Berklee College of Music w Bostonie, Wares podzielił się kilkoma narzędziami muzycznymi AI; Niektóre możesz zacząć uczyć się teraz, a niektóre, o których możesz po prostu dowiedzieć się.

Bandlab Songstarter

Aplikacja Bandlab's Songstarter to generator piosenek zasilany przez AI, który pozwala wybrać gatunek, wprowadzić teksty piosenek (i emoji), i generuje bezpłatne pomysły. Następnie możesz zabrać te pomysły do funkcji studyjnej, aby uczynić je własnymi. To świetny sposób na rozpoczęcie piosenki, jeśli potrzebujesz początkowej inspiracji.

Midjourney

Jako jeden z najpopularniejszych generatorów obrazów napędzanych AI, Midjourney może być używany do tworzenia sztuki albumu, okładek piosenek, plakatów, pętli Spotify, zdjęć i innych. To, co wyróżnia go od innych generatorów obrazów napędzanych sztucznej inteligencji, jest jego surrealistyczne, podobne do snów styl, który może być lepiej dostosowany do projektów muzycznych. Program jest łatwy w użyciu, ale istnieje określona krzywa uczenia się. Podobnie jak wiele nowych programów technologicznych, przed nurkowaniem obejrzyj kilka samouczków.

Mieszaj monolit

Wtyczka mix monolith to automatyczny system miksowania z Ayaic, który wyrówna twoją miks. W artykule Mix Online deweloper mówi: „Jego celem nie jest automatyczne tworzenie gotowego miksu, ale ustanowienie podstawowych relacji między torami i zapewnienie odpowiednich dostosowania wzmocnienia”.

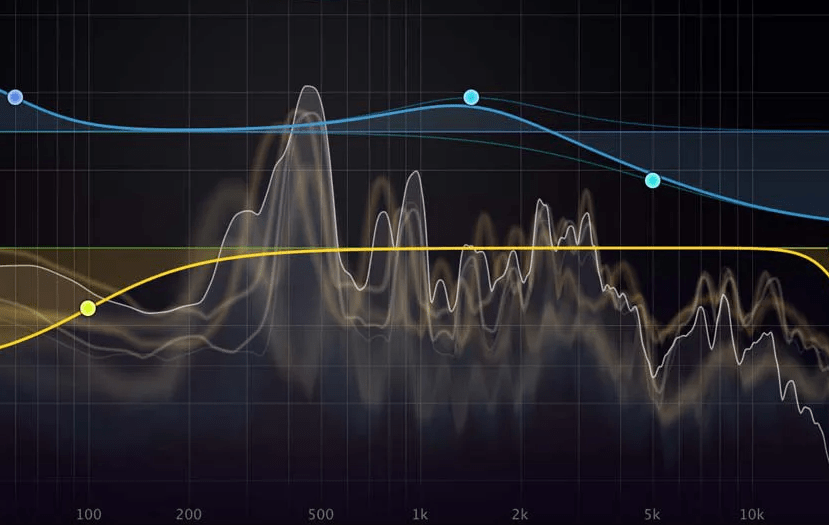

Landr Ai Mastering

Narzędzie Mastering AI Landr pozwala przeciągnąć i upuszczać ścieżkę do programu, który następnie go analizuje i oferuje proste opcje stylu i woluminu. Po wybraniu tych dwóch opcji program opanuje Twoją ścieżkę, dając więcej opcji typu pliku i metody dystrybucji. Landr oferuje ponad 20 milionów utworów, które zostały zmieszane z ich programem.

Aiva

Aiva to program sztucznej inteligencji, który został przeszkolony na temat ponad 30 000 kultowych wyników z historii. Możesz wybierać spośród kilku różnych wstępnie ustawionych stylów muzycznych, od współczesnego kina po kino XX wieku, od tango po jazz. Następnie masz opcję wprowadzenia kluczowego podpisu, podpisu czasu, tempa, oprzyrządowania, czasu trwania i innych. Jeśli nie wiesz, co wejść, Aiva zrobi to za Ciebie. Na koniec możesz wygenerować ścieżkę, dostosować oprzyrządowanie i przesłać różne typy plików. Jako subskrybent masz pełną licencję na prawo autorskie na wszystko, co tworzysz.

Chatgpt dla muzyków

Jedno z najczęściej używanych narzędzi AI, Chatgpt Openai ma różne zastosowania dla muzyków. Spółka jest obecnie badana przez Federalną Komisję Handlu, więc powinieneś podjąć środki ostrożności dotyczące informacji, które udostępniasz z Chatgpt, a także zweryfikować wszelkie fakty otrzymujące od Chatgpt.

Mając to na uwadze, program może skrócić czas spędzony na zadaniach, które odciągają cię od tworzenia muzyki. Wares i Camp eksperymentują z Chatgpt od jego wydania i mają pewne szczególne wskazówki, które muzycy i profesjonaliści muzyczni mogą uznać za przydatne.

Strategia mediów społecznościowych

Media społecznościowe mogą być ogromnym zlewem dla amatorskiego muzyka, a Chatgpt może pomóc w złagodzeniu ładunku. Wares mówi, że możesz zacząć od opowiedzenia Chatgpt, jakim jesteś artystą, jakim gatunkiem muzyki grasz i jakie są twoje hobby i zainteresowania. Następnie możesz poprosić o 30 fragmentów treści przez następne 30 dni w Tiktok, Instagramie, Facebooku lub dowolnej platformie mediów społecznościowych. Nie tylko możesz poprosić o pomysły na treści w mediach społecznościowych, ale możesz również poprosić Chatgpt o stworzenie zoptymalizowanych podpisów i hashtagów.

Techniczni jeźdźcy do zwiedzania

Podczas trasy koncertowej muzycy zwykle zatrudniają kogoś, kto utworzył technicznego jeźdźca, który nakreśla wszystkie szczegóły potrzebne do wykonania swojego programu. Może to obejmować sprzęt, konfigurację sceny, inżynierię dźwięku, oświetlenie, gościnność, kontrakty koncertowe, trasy wycieczki, opcje miejsc, ceny biletów i wiele innych. Wares twierdzi, że Chatgpt może napisać tego jeźdźca technologicznego, a ostatnio współpracował z zespołem, aby zaplanować swoją wycieczkę za pomocą technologii.

„Zaczęliśmy od utworzenia ich jeźdźca technologicznego, który zawierał wymagania zaplecza, szczegółową listę danych wejściowych, a nawet określone zalecenia mikrofonowe, wszystkie oparte na kilku prostych wskazówkach”, mówi Wares. „Następnie poprosiliśmy o rekomendacje dotyczące podróży trasy na północnym wschodzie, ile powinniśmy pobierać opłat za bilety i pomysły na towary oparte na unikalnych zainteresowaniach i demografii bazy fanów zespołu. To, co zajęłoby dni w niecałą godzinę. ”

Pisanie tekstów piosenek

Jeśli potrzebujesz pomocy w pisaniu tekstów piosenek, potrzebujesz inspiracji lub chcesz użyć sugestii słów, Chatgpt może być przydatnym narzędziem pisania piosenek. Camp podaje przykład współpracy z byłą studentką Berklee Julią Perry (która przeprowadziła wywiady z nimi w artykule Berklee o sztucznej inteligencji i muzyce) w celu wygenerowania pomysłów na piosenki za pomocą Chatgpt.

„Mówiliśmy o tym, jak wszechświat jest magii i jak chciała wyrazić tę głęboką, niepoznawalną prawdę o wszechświecie” - mówi Camp. „I zasadniczo skondensowałem wszystko, co powiedziała w dwóch lub trzech akapitach i powiedziała [Chatgpt], daj mi 20 linii pierwszych dla tej piosenki”.

Skończyli użyć jednej z 20 opcji jako punktu wyjścia do nowej piosenki.

Pisanie treści

Chatgpt może pomóc w różnych zadaniach dotyczących pisania treści i copywriting, niezależnie od tego, czy pisze komunikat prasowy, bio z wieloma długościami postaci, strategią wydania albumu, postu na blogu, kopią strony internetowej, e -maila i innych.

Umowy i umowy

W idealnym świecie miałbyś prawnik pisał i przeglądał wszystkie swoje umowy i umowy, ale nie zawsze jest to realistyczne lub niedrogie. W niektórych przypadkach możesz chcieć, aby Chatgpt opracował umowę, a nie nic nie mieć. Można to wykorzystać do umów zarządzania, umów zespołowych, podzielonych arkuszy, umów o wydajności i innych. Ale znowu prawnik rozrywkowy jest zawsze preferowany, jeśli to możliwe.

Gdzie są ludzie?

Obecny stan muzyki generatywnej AI jest bardziej miksowany niż prawdziwe generowanie. To nie jest tak naprawdę zespół hołdu, ale raczej ekspansywne podejście do ożywienia. Może wytwarzać dźwięki tylko z danych treningowych, i chociaż może łączyć, mieszać i załamać te elementy na nowe sposoby, nie może naprawdę eksperymentować poza tym.

Muzycy powiedzą ci, że istnieje tylko ograniczona liczba nut, które można odtwarzać lub że wszystkie dźwięki są tylko kwestią częstotliwości i długości fali, a zatem istnieje tylko ograniczona ilość tego, co można zrobić w kategoriach czysto muzycznych. Ale muzyka jest coś więcej niż tylko zorganizowanie akordów lub rytmów, podobnie jak tworzenie przepisów jest coś więcej niż tylko wybór z skończonej listy składników i technik.

Ribo jest gitarzystą znanym ze swoich eksperymentów i umiejętności czerpania z różnych wpływów i mieszania ich z czymś nowym. Na pierwszy rzut oka brzmi to bardzo podobnie do propozycji wartości wysuwanej przez zwolenników generatywnej sztucznej inteligencji, ale twierdzi, że istnieją fundamentalne różnice między człowiekiem a maszyną, które robią to samo.

„Nie mogę przejść przez 12-barowy bluesowy solo bez cytowania kogoś”-powiedział Ribot. „Musimy dać do tego przywilej praw człowieka. Jestem całkiem dobry w wiedzy, kiedy przekraczam linię. Wiem, że mogę zacytować tę część piosenki Charliego Parkera, nie jest to piosenka Charliego Parkera, i wiem, że mogę to bardzo spieprzyć i będzie fajnie ”.

Album Ribot z 1990 roku Cosmopolitans obejmuje okładkę „The Wind Cry Wind Mary” Jimi Hendrix. W hołdzie dla Hendrix wersja Ribot jest abstrakcyjna, teksty szczekały się nad zarysowatą gitarą, nie przypominając oryginalnej piosenki innej niż ton gitarowy, pomijając melodię, akordy i rytm Hendrixa. Mimo to Ribot wymienił go jako okładkę na albumie i płaci mechaniczną opłatę królewską na każdej sprzedaży lub strumieniu.

„Ten system musi zostać zachowany i warto go walczyć” - powiedział Ribot. „Nie płacimy minimalnej płacy, kiedy siedzimy na płycie. Nie mamy gwarancji, nawet gdy występujemy. [Prawa autorskie] jest dosłownie jedynym prawem ekonomicznym. ”

Praktyka dyskursywna Ribota jest częścią długiej tradycji: muzyka jako medium jest definiowana przez świadomość i szacunek dla tego, co stało się wcześniej, to, co może się rozwijać i zmienić, a nie tylko recyklingować. „To, co napędza zmianę muzyki to zmiany w nastrojach ludzi, ich potrzeb i możliwości oraz tego, co kochają i co ich wkurza. Ludzie mogą nauczyć się brać uczucia, wydarzenia i pełnię życia i reprezentować ich na gitarze lub fortepianie. Rozszerza pole, gdy doświadczenie się rozszerza, wydłuża się historia, a pojawiają się zespoły, które wymagają ekspresji i pomysłów. ”

Historycznie istniała święta umowa między muzykami i publicznością, która implikuje autentyczność i ludzkość. Spośród milionów fanów Taylor Swift, którzy uczestniczyli w trasie Eras, wielu może dać ci szczegółowy opis jej życia osobistego. To samo dotyczy publiczności Beyoncé, Harry Styles, Elton John lub którykolwiek z największych artystów koncertowych. Potrzebujesz prawdziwej osoby do sprzedaży stadionów. Nikt nawet nie oglądałby zamaskowanego piosenkarza, gdyby nie sądzili, że rozpoznają wykonawców, gdy zostali zdemaskowani.

Kiedy celowo słuchamy muzyki, często słuchamy hermeneutycznie, jakby piosenka była drzwią do większej przestrzeni zrozumienia doświadczeń i perspektyw innych ludzi. Rozważ nirwanę. Ponieważ estetyczna dewiacja Grunge spotkała nowoczesną technologię studyjną we właściwym momencie, Nevermind znalazła ogromną publiczność nie tylko ze względu na to, jak to brzmi, ale także dlatego, że osobisty łuk Kurta Cobaina - meteoryczny wzrost i tragiczna wczesna śmierć niespokojnego dzieciaka podmiejskiego, który stał się Rock Superstar poprzez otwarcie trudne (niektóre) konwencje gwiazdy pop-powiązane z ludźmi.

Podczas gdy zespół uznał muzyków, którzy ich zainspirowali - pixies, gap band i inni - płyty z Nirvany są ostatecznie unikalnym produktem wyborów dokonanych przez Cobaina, jego kolegów z zespołu i ich współpracowników, wyraz i odbicie ich doświadczeń i ideałów . Sztuka z definicji jest produktem podejmowania decyzji przez ludzi.

Niektóre muzyka generowana przez AI, podobnie jak inne formy procesu muzycznego, nadal zachowują ten ludzki element: ponieważ artyści tacy jak Ivan Paz i Shelley Knotts w dużej mierze polegają na automatycznych modelach, tworzą system, podejmują niezliczone decyzje dotyczące tego, jak działa i decydują, co to zrobić Zrób wszelkie dźwięki, które produkuje.

Ale muzyka AI, która zagraża ludzkim muzykom, która przyjmuje niewiele więcej niż kilka słów i produkuje od nich całe piosenki, jest z natury ograniczona, ponieważ może wyglądać tylko do wewnątrz i zacofać w czasie, nigdy nie na zewnątrz, a zatem nigdy do przodu. Gitara została wynaleziona stuleci temu, ale model AI trenowany w zakresie muzyki przed czasem świetności siostry Rosetty Tharpe w latach 40. XX wieku raczej nie wytworzy czegokolwiek przypominającego gitarę elektryczną. Hip-hop to styl muzyki oparty na próbkowaniu i przepakowaniu pracy innych artystów (czasami w formach lub kontekstach, których oryginalny artysta nie lubi), ale model wyszkolony w zakresie muzyki przed 1973 rokiem nie będzie w stanie stworzyć czegoś takiego To.

Istnieje niezliczone powody, dla których ludzie słuchają muzyki, ale istnieje tyle powodów, dla których ludzie to robią. Ludzie wydawają sobie nawzajem od tysięcy lat i przez większość czasu byłoby głupio wyobrażać sobie, że zarabia na życie - byłoby niemożliwe, aby nawet myśleć o wzmocnieniu go, nie mówiąc już o tym. Ludzie i tak tworzyli muzykę.

Jest tu napięcie, które poprzedza AI. Z jednej strony, etykiety płytowe i cyfrowe platformy strumieniowe uważają, w dużej mierze poprawnie, że rynek muzyczny chce przede wszystkim uznania, tak wiele pieniędzy pochodzi ze sprzedaży katalogów uznanych artystów, a jeden raport sugeruje, że sprzedaż te stanowiła 70 Procent amerykańskiego rynku muzycznego w 2021 r. Algorytmy platformy streamingowej często nadają te same utwory w kółko.

Z drugiej strony istnieje wewnętrzna ludzka potrzeba zaskoczenia, innowacji, wykroczenia. Jest inaczej dla każdej osoby. Cele ogromnej korporacji - w zasadzie skali i nadzoru - różnią się od celów jej użytkowników jako całości i dla jednostki, a im większa staje się jej baza użytkowników, tym bardziej będzie się automatyzować. Ani generatory muzyki AI, ani dynamicznie generowane listy odtwarzania, ani żaden inny system predykcyjny algorytmicznie nie są z natury dobre, ani złe: wyniki zależą całkowicie od tego, kto je uruchamia i w jakim celu.

Ale cokolwiek się stanie, żadna firma nigdy nie będzie miała monopolu na muzykę. Żaden gatunek nie ma. Ptaki to robią. Pszczoły to robią. Robią to wieloryby na morzu. Niektóre z nich, dla ludzkiego ucha, są całkiem piękne. Ale nawet z całą tą naturalną melodią, cała muzyka już stworzyła, a cała muzyka, którą AI pomoże albo stworzyć, albo stworzyć, ludzka potrzeba tworzenia i wyrażania siebie. Muzyka istnieje w naszym świecie z powodów innych niż komercjalizm.

Najczęściej powód jest dość prosty: osoba lub grupa ludzi zdecydowała, że powinna istnieć, a potem tak się stało. Będzie nadal istnieć, bez względu na to, ile osadu dźwiękowego wypompowują maszyny.

Objąć lub opierać się?

Jednym z powtarzających się tematów, jeśli chodzi o sztuczną inteligencję i inne pojawiające się technologie, jest to, że będą one dużą częścią branży muzycznej (i większości branż) w przyszłości i ignorowanie ich nie pomoże przyszłym liderom branży.

„Myślę, że sztuczna inteligencja może pomóc moim uczniom być bardziej produktywnym i wesprzeć ich proces twórczy i pozwolić im skupić się na tym, co najważniejsze dla nich, która tworzy i wykonywanie muzyki lub odkrywanie nowych pomysłów biznesowych”, mówi Wears. „Jednak jako odpowiedzialny pedagog muszę się upewnić, że moi uczniowie nie uzależniają się od tych narzędzi, a ja nieustannie szukam sposobów korzystania z AI, aby pomóc w rozwijaniu ich umiejętności krytycznego myślenia”.

Obóz zgadza się, a także zachęca ludzi do robienia tego, z czym są wygodne, ponieważ AI nadal się rozwija.

„Z pewnością zachęcam cię, jeśli chcesz pozostać na bieżąco i wykorzystać technologię, aby rozwijać to, na co jesteś na planecie, to tak, dołącz”, mówi Camp. „Ale jak powiedziałem, mam przyjaciół, którzy korzystają z linii stacjonarnej. Mam przyjaciół, którzy wolą kupować płyty winylowe. AI jest tutaj. Ma to ogromny wpływ. Nie musisz go używać, ale wiele osób decyduje się. ”

AI w Berklee Online

Niedawno Berklee Online rozpoczęła inicjatywę o nazwie Aria: AI-Hipanced Reality & Immerive Applications. Projektem jest Gabriel Raifer Cohen, zastępca dyrektora ds. Wsparcia i technologii audio w Berklee Online oraz absolwent Berklee College of Music.

„Podobnie jak kalkulatory, komputery, Internet i wyszukiwarki przed nim Genai pozostanie”, mówi Raifer Cohen. „Ignorowanie rzeczywistości, że wszystkie te narzędzia są łatwo dostępne, jest szkodliwością dla uczniów. . . . Uczenie uczniów, jak najlepiej - i odpowiedzialne - wykorzystanie tych technologii jako narzędzi wzmocnienia może być bardziej wartościowym przedsięwzięciem niż próba walki z nimi. ”

A tylko dlatego, że sztuczna inteligencja odegra ważną rolę w przyszłości branży muzycznej, nie oznacza, że nie możemy krytykować tej nowej technologii ani opowiadać się za środkami bezpieczeństwa. „Jednocześnie musimy oprzeć się rozprzestrzenianiu się mierności i twórczej niewrażliwości napędzanej bezmyślnym użyciem Genai, pozostając etycznie świadomym i proaktywnym”, mówi. „Nie ma w tym nic łatwego, ale musimy wziąć pod uwagę, że zmiany w sztucznej inteligencji otwierają również możliwości potencjalnie transformacyjnych doświadczeń edukacyjnych”. Raifer Cohen mówi, że w ramach inicjatywy ARIA Berklee Online będzie nadal eksplorować te nowe narzędzia i dopiero po ich przetestowaniu i dokładnym zbadaniu szkoły rozważy ich wdrożenie w klasie. „Ostatecznie nie możemy zapominać, że dla uczniów i nauczycieli, widzów i twórców wszystkie te potężne narzędzia są po prostu takie: narzędzia”, mówi Raifer Cohen.