Audionormalisierung

In den letzten drei Jahrzehnten hat sich die Art und Weise, wie wir auf Musik zugreifen, radikal verändert. Mit dem Aufkommen digitaler Streaming-Dienste und der digitalen Signalverarbeitungstechnologie (DSP) ist die Standard-Audionormalisierung zu einem integralen Bestandteil dieses Prozesses geworden.

Aber was bedeutet Audionormalisierung und wie können Sie diesen Prozess mit Ihren eigenen digitalen Audiodateien durchführen? Schauen wir uns an, was Klangnormalisierung ist und warum sie eine Schlüsselphase der modernen musikalischen Kreativität ist.

Der Online-Sequenzer Amped Studio verfügt über eine vollständige Liste an Funktionen zur vollständigen Audionormalisierung, mit denen Sie Ihre Tracks professionell bearbeiten können.

Was ist Audionormalisierung?

Während des Audionormalisierungsprozesses wenden Sie eine bestimmte Verstärkung auf eine digitale Audiodatei an, die sie auf einen bestimmten Amplituden- oder Lautstärkepegel bringt und gleichzeitig den Dynamikbereich der Spuren beibehält.

Die Audionormalisierung wird häufig verwendet, um die Lautstärke eines ausgewählten Audioclips zu maximieren und die Konsistenz zwischen verschiedenen Audioclips sicherzustellen, beispielsweise in einem Album oder einer EP, die mehrere Titel enthält.

Es ist wichtig zu beachten, dass es schwieriger sein kann, Kompositionen mit einem großen Dynamikbereich effektiv zu normalisieren. Während des Normalisierungsprozesses können Probleme wie Abflachung oder Verzerrung der Spitzenamplitude auftreten.

Daher erfordert jeder Audioclip einen individuellen Ansatz bei der Normalisierung. Die Audionormalisierung ist ein integraler Bestandteil der digitalen Aufnahmeverarbeitung, es gibt jedoch keinen einheitlichen Ansatz für den Prozess.

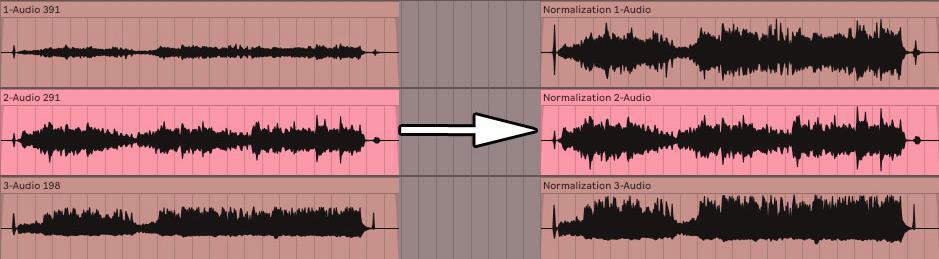

Vor und nach der Audionormalisierung

Warum müssen Sie den Ton normalisieren?

Warum ist es so wichtig, Audiodateien zu normalisieren? Hier sind einige Szenarien, in denen eine Volumennormalisierung ein Muss ist:

Vorbereitung auf die Arbeit mit Streaming-Diensten

Streaming-Dienste legen automatisch eine Standardlautstärke für alle Titel in ihren Bibliotheken fest, sodass Sie die Lautstärke nicht während des Hörens anpassen müssen. Jede Plattform verfügt über ihre eigenen Ziel-LUFs, um einen konsistenten Klang zu gewährleisten:

- • Spotify : -14 LUFS;

- • Apple Music : -16 LUFS;

- • Amazon Music : von -9 bis -13 LUFS;

- • Youtube : von -13 bis -15 LUFS;

- • Deezer : von -14 bis -16 LUFS;

- • CD : -9 LUFS;

- • Soundcloud : von -8 bis -13 LUFS.

Obwohl jeder Tontechniker möglicherweise einen anderen Ansatz zur Bestimmung der Ziellautstärke für das Mastering verfolgt, sind diese Standards wichtige Richtlinien, um eine konsistente Musikwiedergabe auf allen Plattformen sicherzustellen.

Erreichen der maximalen Lautstärke

Mithilfe der Audionormalisierung können Sie für jede Audiodatei den maximalen Lautstärkepegel erreichen. Dies ist besonders nützlich, wenn Sie Titel in Audiobearbeitungsprogramme importieren oder die Lautstärke einer einzelnen Audiodatei erhöhen möchten.

Erstellen einer einzelnen Ebene zwischen mehreren Audiodateien

Es ist auch möglich, Audiodateien auf den gleichen Lautstärkepegel zu konditionieren, was für Prozesse wie das Mastering wichtig ist, bei denen es notwendig ist, geeignete Audiopegel für die spätere Verarbeitung einzustellen.

Darüber hinaus können Sie nach Abschluss eines Musikprojekts wie eines Albums oder einer EP die Audiodateien normalisieren und bearbeiten. Da Sie möchten, dass die Atmosphäre und der Klang der gesamten Aufnahme einheitlich sind, müssen Sie möglicherweise noch einmal zurückgehen und die Lautstärke anpassen, um sie an alle Songs anzupassen.

Zwei Arten der Klangnormalisierung

Für unterschiedliche Verwendungszwecke von Audioaufnahmen werden unterschiedliche Klangnormalisierungsmethoden verwendet. Dies lässt sich normalerweise auf zwei Haupttypen reduzieren: Spitzennormalisierung und Lautstärkenormalisierung.

Peak-Normalisierung

Der Peak-Normalisierungsprozess ist eine lineare Methode, bei der das Audiosignal gleichmäßig angehoben wird, um einen Pegel zu erreichen, der der maximalen Amplitude der Audiospur entspricht. Der Dynamikbereich bleibt gleich und die neue Audiodatei klingt ungefähr gleich, außer dass die Lautstärke höher oder niedriger sein kann. Dieser Prozess bestimmt den höchsten PCM-Wert oder Pulscodemodulationswert in einer Audiodatei. Der Kern der Spitzennormalisierung besteht darin, Audiodaten basierend auf der Obergrenze eines digitalen Audiosystems zu verarbeiten, die typischerweise einer maximalen Spitze bei 0 Dezibel entspricht. Der Spitzennormalisierungseffekt basiert ausschließlich auf Spitzenaudiopegeln und nicht auf der wahrgenommenen Lautstärke des Titels.

Volumennormalisierung

Der Prozess der Lautheitsnormalisierung ist komplexer, da er die Eigenschaften der menschlichen Schallwahrnehmung berücksichtigt. Das menschliche Ohr ist mit gewissen subjektiven Einschränkungen in der Lage, unterschiedliche Lautstärken und Amplituden einzelner Geräusche zu unterscheiden. Diese Verarbeitung wird oft als EBU R 128-Lautheitsbestimmung bezeichnet.

Beispielsweise können Töne, die über einen längeren Zeitraum mit der gleichen Lautstärke abgespielt werden, lauter erscheinen als Töne, die intermittierend oder kurzzeitig abgespielt werden, selbst wenn die Lautstärke gleich ist. Dies liegt an der Art und Weise, wie das menschliche Ohr Schall wahrnimmt. Daher ist es bei der Normalisierung der Lautstärke notwendig, diese Wahrnehmungsmerkmale zu berücksichtigen.

Manche Leute finden, dass lautere Musik attraktiver klingt. Aus dieser Vorstellung heraus entstanden die „Lautheitskriege“ vor dem Aufkommen von Streaming-Diensten, bei denen Musiker versuchten, die Spitzenlautstärke ihrer Aufnahmen zu maximieren, um einen markanteren und farbenfroheren Klang zu erzeugen. Dank der Klangnormalisierung gehört dieses Phänomen jedoch der Vergangenheit an und der Übergang zwischen den Titeln wird nicht mehr von plötzlichen Lautstärkeänderungen begleitet.

LUFs werden verwendet, um Lautstärkepegel zu messen, die der menschlichen Wahrnehmung von Schall besser entsprechen. Dieser Standard wird häufig in Film-, Fernseh-, Radio- und Streaming-Diensten verwendet. Wie bei der Spitzennormalisierung bleibt 0 dB der Standard.

Die Fletcher-Munson-Kurve kann, wie oben angegeben, dabei helfen, die Unterschiede zu erklären, die bei der Lautheitsnormalisierung in LUFs berücksichtigt werden.

Die Lautstärkestandards variieren je nach Region und Anwendung

- 24 LUFS: ATSC A/85 (amerikanisches Fernsehen), NPRSS, PRX-Radiosendung;

- 23 LUFS: Übersetzung von EBU R 128;

- -19 bis -16 LUFS: PRX-Podcasts;

- 14 LUFS: Spotify, YouTube und andere Streaming-Plattformen.

Bestimmung des quadratischen Mittelvolumens

Wenn Sie Stereokanäle nicht mithilfe der Spitzenpegelnormalisierung normalisieren möchten, verwenden Sie wahrscheinlich die Lautheitsnormalisierung. Erwähnenswert ist jedoch auch die Erwähnung einer anderen Lautheitsverarbeitungstechnik, der RMS-Lautheit.

Der Normalisierungsprozess ähnelt der Lautheitsnormalisierung in LUFs, es werden jedoch stattdessen RMS-Pegel verwendet. Der quadratische Mittelwert (RMS) misst die durchschnittliche Lautstärke eines Abschnitts oder der gesamten Dauer eines Clips.

Allerdings berücksichtigt die RMS-Normalisierung ebenso wie die auf dem höchsten Spitzenwert basierende Normalisierung nicht das menschliche Gehör. Aus diesem Grund arbeiten Mastering-Ingenieure typischerweise standardmäßig mit LUFs und Normalisierungsprozessen. Beim Mastering geht es nicht nur darum, sicherzustellen, dass die Lautstärken während des gesamten Projekts konsistent sind. Es ist auch wichtig, einen Schritt zurückzutreten und die Dynamik, die menschliche Wahrnehmung und die Ausgewogenheit zwischen den einzelnen Titeln zu berücksichtigen.

Wann sollte die Normalisierung verwendet werden?

Nachdem Sie nun verstanden haben, was Audionormalisierung ist, besprechen wir, wann und wie sie verwendet werden sollte.

Beherrsche deine Musik

Die Audionormalisierung ist ein wichtiges Werkzeug im Track-Mastering-Prozess.

Beim Mastering ist es wichtig, die Lautstärke Ihrer Tracks konstant zu halten.

So können Ihre Zuhörer ihre Musik genießen, ohne ständig die Lautstärke anpassen zu müssen.

Durch die Normalisierung Ihrer Tracks, beispielsweise beim Erstellen eines Postmixes/Masters für Ihr Album, können Sie einen professionellen, ausgefeilten Sound erzielen.

Eines, das den kommerziellen Veröffentlichungsstandards entspricht und zur Verteilung bereit ist.

Apropos Mastering: Wenn Sie nach den besten Mastering-Plugins suchen, sind wir hier, um Ihnen bei der Suche zu helfen.

Vorbereitung auf Streaming-Dienste

Für Streaming-Dienste gelten bestimmte Lautstärkeanforderungen, die beim Herunterladen von Musik berücksichtigt werden müssen.

Die Normalisierung kann Ihnen dabei helfen, diese Anforderungen zu erfüllen und auf diesen Plattformen eine hervorragende Audioqualität bereitzustellen.

Indem Sie Dateien normalisieren, um sie an die Zielebene des Streaming-Dienstes anzupassen, stellen Sie eine gleichbleibende Wiedergabequalität für Ihre Fans sicher.

Wenn Sie diesen Prozess jedoch nicht selbst durchführen, können Streaming-Dienste ihn mithilfe von Komprimierung, Begrenzung und anderen Techniken für Sie erledigen.

Dies kann zu ernsthaften Problemen mit der Audioqualität führen.

Denken Sie immer daran, die Lautstärkeempfehlungen für jeden einzelnen Streaming-Dienst zu prüfen, da die Anforderungen variieren können.

Arbeiten mit verschiedenen Audiodateien

Wenn Sie in einem Projekt mit mehreren Audiodateien arbeiten, ist es wichtig, dass die Lautstärke für alle gleich bleibt.

Dies ist besonders wichtig, wenn die Audiodateien unterschiedliche Quellen haben oder mit unterschiedlichen Lautstärken aufgenommen wurden.

Dies ist besonders wichtig, wenn die Audiodateien unterschiedliche Quellen haben oder mit unterschiedlichen Lautstärken aufgenommen wurden.

Dies ist besonders wichtig, wenn die Audiodateien unterschiedliche Quellen haben oder mit unterschiedlichen Lautstärken aufgenommen wurden.

Häufige Missverständnisse über die Audionormalisierung

Ich denke, es ist sehr wichtig, einige häufige Missverständnisse zu berücksichtigen, bevor man weitermacht, insbesondere für diejenigen, die gerade erst anfangen.

1. Tonnormalisierung und -komprimierung sind zwei verschiedene Dinge

Manche Leute verwechseln Normalisierung und Komprimierung, aber sie verfolgen völlig unterschiedliche Zwecke.

Während durch die Normalisierung die Gesamtlautstärke einer Audiodatei angepasst wird, verringert die Komprimierung den Dynamikbereich der Datei.

Die Komprimierung kann dazu beitragen, eine stabilere Lautstärke innerhalb einer Audiodatei zu erzeugen, sie erhöht jedoch nicht unbedingt die Gesamtlautstärke der neuen Audiodatei.

Es sei denn, das ist natürlich Ihr Ziel.

Komprimierung wird typischerweise zur dynamischen Korrektur und Klangverbesserung verwendet, während die Normalisierung eher eine nützliche Funktion ist.

Wenn Sie nach den besten Kompressor-Plugins für diesen Prozess suchen, sind Sie hier genau richtig.

2. Die Normalisierung des Tons behebt nicht alles

Es ist wichtig zu bedenken, dass die Spitzennormalisierung nicht alle Audioprobleme löst.

Wenn Sie Probleme mit dem Signal-Rausch-Verhältnis, Verzerrungen oder anderen Audioartefakten haben, können diese Probleme durch Normalisierung allein nicht gelöst werden.

In solchen Fällen müssen Sie die Grundursachen des Problems angehen und andere Audioverarbeitungstechniken wie Equalizer oder Rauschunterdrückung verwenden, um den gewünschten Klang zu erzielen.

Für den Fall einer solchen Situation haben wir die besten Equalizer-Plugins des Jahres 2023.

3. Die Schallnormalisierung erhöht nicht die Leistungsreserven

Beim Normalisieren von Audiodateien ist es wichtig, in Ihren Mischungen und Aufnahmen ausreichend Lautstärkespielraum beizubehalten.

Der Headroom ist der Unterschied zwischen dem lautesten Punkt in Ihrer Audiodatei und dem maximalen Lautstärkepegel, den Ihr digitales Audiosystem verarbeiten kann.

Wenn Sie Ihre Audiodaten zu aggressiv normalisieren, riskieren Sie Verzerrungen und Übersteuerungen, die sich negativ auf die Qualität Ihrer Musik auswirken können.

Denken Sie daran, dass es unabhängig davon, welche DAW oder welches System Sie verwenden, wichtig ist, alles zu überwachen, was über der 0-dB-Marke liegt.

Denn durch die Vermeidung der Beschränkung und eine ausreichende Marge werden Verzerrungen vermieden.

Ich betrachte zum Beispiel gerne -16 dB als meinen Headroom-Zielwert und verwende für alles, was darüber liegt, einen Begrenzer (nur um ausreichend Headroom aufrechtzuerhalten).

Dies hilft auch dabei, eventuell notwendige Lautstärkeänderungen während der Mastering-Phase auszugleichen.

Klangnormalisierungsprozess

Nachdem wir nun die häufigsten Missverständnisse über die Audionormalisierung behandelt haben, wollen wir tiefer in den Prozess selbst eintauchen.

Analysieren Sie Ihre Audiodateien

Vor dem Normalisieren von Audiodateien ist es wichtig, diese zu analysieren und die aktuellen Lautstärkepegel zu ermitteln.

Diese Analyse kann mit in Ihre DAW integrierten Tools oder mit einer speziellen Audioanalysesoftware durchgeführt werden.

Indem Sie die aktuellen Lautstärkepegel Ihrer Dateien kennen, können Sie fundierte Entscheidungen über den Audionormalisierungsprozess treffen.

Auswählen eines Audionormalisierungsziels

Nach der Analyse der Dateien können Sie das Normalisierungsziel auswählen, das Ihren Anforderungen am besten entspricht.

Zu den bei der Auswahl einer Normalisierungsmethode zu berücksichtigenden Faktoren gehören:

- Art des Audiomaterials;

- Gewünschter Lautstärkepegel;

- Art der durchgeführten Verarbeitung;

- Zielplattform für Ihre Musik.

Jede Normalisierungsstufe hat ihre eigenen Stärken und Schwächen. Daher ist es wichtig, diejenige zu wählen, die für Ihre spezifische Situation die besten Ergebnisse liefert.

- In Mischsituationen . Bleiben Sie im niedrigen zweistelligen Bereich, idealerweise -18 bis -12 dB;

- Für Mastering-Zwecke . Eine sichere Option wäre ein Wert zwischen -8 und -3 dB.

Bei einigen Streaming-Diensten und -Situationen kann es vorkommen, dass -0 dB garantiert ist. Stellen Sie daher sicher, dass dieser Wert nicht überschritten wird, da er direkt am Rande des Grenzwerts liegt.

Notiz. Während des Mischvorgangs ist es wichtig, genau auf die Verstärkungseinstellungen zu achten und die RMS-Lautstärke zu bestimmen, um die erforderliche Verstärkung für jede Spur zu bestimmen.

Mit der Verstärkungsregelung des Clips können Sie die Lautstärke präzise steuern und so eine ausgewogene Mischung gewährleisten.

Klangnormalisierung

Nachdem Sie das entsprechende Normalisierungsziel ausgewählt haben, können Sie die Audiodateien mit einer DAW oder einer speziellen Audiobearbeitungssoftware bearbeiten.

Die meisten DAWs und Audiobearbeitungsprogramme verfügen über integrierte Normalisierungstools, die ihre Verwendung erleichtern.

In der Regel ist dies so einfach wie das Hervorheben des Audiosignals und das Drücken des Befehls oder einfach die Auswahl von „Normalisieren“ aus dem Dropdown-Menü.

Achten Sie darauf, die Ergebnisse des Normalisierungsprozesses zu überwachen, um sicherzustellen, dass die neuen Lautstärkepegel Ihren Erwartungen entsprechen und keine unerwünschten Artefakte oder Probleme verursachen.

Komprimierung vs. Normalisierung

Wenn es um Normalisierung geht, wird sie am häufigsten mit dem Komprimierungsprozess verglichen. Die Unterschiede zu verstehen und die richtige Audioverarbeitungsmethode auszuwählen, sind Schlüsselkompetenzen für einen Musikproduzenten, also schauen wir uns das genauer an.

Komprimierung und Normalisierung sind zwei separate Audioverarbeitungstechniken mit jeweils eigenen Zielen.

- Die Normalisierung zielt darauf ab, die Gesamtlautstärke einer Audiodatei anzupassen.

- Durch die Komprimierung wird wiederum der Dynamikbereich innerhalb der Datei verringert.

Es ist wichtig zu bedenken, dass durch die Komprimierung leisere Teile einer Audiodatei lauter und lautere Teile leiser werden. Obwohl beide Methoden verwendet werden können, um eine gleichmäßigere Lautstärke zu erreichen, wirken sie sich unterschiedlich auf den Klang aus und können unterschiedliche Auswirkungen auf Ihr Material haben.

Ja, Komprimierung kann den Ton lauter machen, aber ihr Hauptzweck ist ein anderer.

Wann Komprimierung verwendet werden sollte

Die Normalisierung ist ein praktischer Prozess, wenn Sie die Gesamtlautstärke einer Audiodatei oder einer Gruppe von Dateien ausgleichen müssen. Wie bereits erwähnt, ist dies besonders nützlich, wenn Sie Ihren Audiotrack mastern oder Musik für Streaming-Dienste vorbereiten. Im Gegensatz zur Komprimierung wirkt sich die Normalisierung nicht auf den Dynamikbereich einer Audiodatei aus, was sie zu einer transparenteren und weniger aufdringlichen Verarbeitungsmethode macht. Darüber hinaus impliziert es auch keine dynamischen, korrigierenden oder verbessernden Ziele, Bedeutungen oder Eigenschaften.

Wann sollte die Volumennormalisierung verwendet werden?

Normalisierung ist ein Werkzeug, das verwendet werden sollte, wenn Sie die Gesamtlautstärke einer Audiodatei oder einer Gruppe von Dateien ausgleichen möchten. Wie bereits erwähnt, ist dies besonders wichtig, wenn Sie Ihren Audiotrack mastern oder Musik für Streaming-Dienste vorbereiten. Im Gegensatz zur Komprimierung verändert die Normalisierung den Dynamikumfang der Audiodatei nicht, wodurch sie neutraler und weniger aufdringlich für den Klang wird. Darüber hinaus ist es nicht dazu gedacht, die dynamischen Eigenschaften einer Audiodatei zu korrigieren oder zu verbessern.

Dynamik und das menschliche Ohr

Das menschliche Hörsystem ist ein komplexer Mechanismus, der auf unterschiedliche Frequenzen und Lautstärkepegel reagiert. Unsere Wahrnehmung von Schall ist nichtlinear: Änderungen der Lautstärke und Frequenzen werden unterschiedlich wahrgenommen.

Diese nichtlineare Natur der Wahrnehmung muss bei der Normalisierung von Audiodateien berücksichtigt werden, da sie sich darauf auswirken kann, wie Hörer Musik wahrnehmen.

Kurven gleicher Lautstärke oder Fletcher-Munson-Kurven zeigen, wie das menschliche Ohr auf Lautstärke bei verschiedenen Frequenzen reagiert. Sie zeigen, dass das Gehör für bestimmte Frequenzbereiche, insbesondere von 2 bis 5 kHz, empfindlicher und für sehr niedrige und hohe Frequenzen weniger empfindlich ist.

Die Kenntnis dieser Kurven kann dabei helfen, fundierte Entscheidungen über die menschliche Wahrnehmung und die Normalisierung von Audiodateien zu treffen und so konsistentere Audiodaten über verschiedene Frequenzen hinweg bereitzustellen.

Was ist Dynamikbereich?

Der Dynamikbereich ist definiert als der Unterschied zwischen den leisesten und lautesten Teilen einer Audiodatei und spielt eine Schlüsselrolle bei der Musikproduktion, da er die Gesamtwirkung und Emotion eines Stücks prägt.

Ein größerer Dynamikbereich trägt dazu bei, der Aufnahme ein Gefühl von Räumlichkeit und Tiefe zu verleihen, während ein kleinerer Dynamikbereich dafür sorgt, dass sich der Klang satter und aufschlussreicher anfühlt.

Es muss ein Gleichgewicht zwischen der Aufrechterhaltung einer konstanten Lautstärke und der Beibehaltung der Dynamik Ihres Audiomaterials gefunden werden. Zu viel Normalisierung oder Überkomprimierung kann zu einem Verlust des Dynamikumfangs führen, sodass Ihre Musik flach und emotionslos klingt.

Um die Dynamik beizubehalten, ist es wichtig, Spitzennormalisierungsmethoden und -einstellungen zu wählen, die die natürliche Dynamik Ihres Materials berücksichtigen und gleichzeitig die gewünschte Lautstärke (Spitzenamplitude) beibehalten.

Lautstärkekrieg

In der modernen Musikindustrie gibt es einen interessanten Trend namens „Loudness War“. Dieser Begriff beschreibt den Trend einer zunehmenden Gesamtlautstärke aufgenommener Musik in den letzten Jahrzehnten. Es wird angenommen, dass lautere Lieder die Aufmerksamkeit der Zuhörer auf sich ziehen oder besser klingen.

Wenn Sie nach den besten Audio-Samples suchen, die Sie in Ihre Musik integrieren können, ist es wichtig, einen Blick auf die besten kostenlosen Sample-Pakete des Jahres 2023 zu werfen. So können Sie die für Ihre Kreativität am besten geeigneten Klangelemente auswählen.

Eine Erhöhung der Lautstärke von Audioaufnahmen hat jedoch negative Folgen. Dies kann zu einem Verlust des Dynamikumfangs und einer schlechten Klangqualität der Musik führen. Viele Künstler, Tonproduzenten und Hörer wehren sich gegen diesen Trend und fordern dynamischere und natürlichere Tonaufnahmen.

Angesichts dieser Bedenken haben viele Streaming-Dienste wie Spotify und Apple Music damit begonnen, die Lautstärkenormalisierung umzusetzen. Dadurch können Sie beim Hören eine gleichbleibende Klangqualität beibehalten und die Notwendigkeit einer übermäßigen Lautstärke beim Erstellen von Musik reduzieren. Bei dieser Verschiebung liegt der Schwerpunkt auf der Beibehaltung des Dynamikbereichs und der Priorisierung der Klangqualität gegenüber der Lautstärke.

Normalisierung vs. Komprimierung: Was ist der Unterschied?

Viele Menschen glauben fälschlicherweise, dass Normalisierung und Komprimierung dasselbe sind, aber das ist alles andere als wahr. Ziel der Komprimierung ist es, die Mindestlautstärke eines Titels anzuheben und die Maximallautstärke zu senken, wodurch eine gleichmäßigere Gesamtlautstärke entsteht. Im Gegensatz dazu legt die Normalisierung den höchsten Punkt als Spitze der Audiospur fest.

Anschließend wird eine proportionale Verstärkung auf den Rest des Klangs angewendet, wobei die Dynamik, also der Unterschied zwischen den lautesten und leisesten Tönen, erhalten bleibt. Dadurch wird die wahrgenommene Lautstärke basierend auf dem Spitzenpegel effektiv erhöht und gleichzeitig die natürliche Klangqualität beibehalten.

Nachteile der Audionormalisierung

Es ist wichtig zu beachten, dass die Audionormalisierung ihre Nachteile hat. Normalerweise wird es nur in den letzten Phasen der Erstellung von Audiomaterial verwendet. Dies liegt daran, dass die Normalisierung den Audiopegel oft auf einen Spitzenwert innerhalb der digitalen Grenze treibt, was die Möglichkeiten der nachfolgenden Bearbeitung einschränkt.

Es ist nicht ratsam, im Rahmen einer Mehrspuraufnahme einzelne Audiospuren zu normalisieren, die noch gemischt werden müssen. Wenn jede Komponente bereits auf die digitale Decke ausgerichtet ist, kann es bei der gemeinsamen Wiedergabe zu Übersteuerungen kommen.

Darüber hinaus kann die Audionormalisierung einige schädliche Folgen haben. Wenn Sie Audio normalisieren, wird die digitale Verarbeitung in die Audiospur integriert, sodass die Änderungen dauerhaft bleiben. Daher ist es wichtig, die Normalisierung im richtigen Kontext und zum richtigen Zeitpunkt anzuwenden – normalerweise nachdem die Audiodateien bereits wie gewünscht verarbeitet wurden.

Registrieren Sie sich kostenlos und erhalten Sie ein Projekt gratis